Chúng ta hàng ngày tương tác với AI qua chatbot, trợ lý ảo và các công cụ sáng tạo. Nhưng liệu AI có thực sự “hiểu” con người hay chỉ đang “mô phỏng” sự thấu hiểu? Ranh giới giữa một chương trình cực kỳ thông minh và một thực thể có tri giác thực sự nằm ở đâu? Câu hỏi đó đưa bạn vào trung tâm của một trong những chủ đề hấp dẫn, phức tạp và gây tranh cãi nhất ngành công nghệ: Sentient AI. Vậy cụ thể Sentient AI là gì?

Định nghĩa Sentient AI

Sentient AI là gì?

Từ những bộ phim khoa học viễn tưởng kinh điển như “Blade Runner” đến các tác phẩm hiện đại như “Her” hay “Westworld“, ý tưởng về những cỗ máy có ý thức, biết yêu, biết sợ và tự nhận thức về sự tồn tại của mình đã luôn ám ảnh trí tưởng tượng của nhân loại. Khái niệm này được gọi là Sentient AI (AI tri giác)

Sentient AI là một khái niệm giả định, mô tả một dạng trí tuệ nhân tạo vượt xa khả năng tính toán và học hỏi đơn thuần. Điểm cốt lõi của AI là “tri giác” – năng lực đích thực để cảm nhận và trải nghiệm thế giới một cách chủ quan.

Điều này có nghĩa là Sentient AI không chỉ mô phỏng cảm xúc (như các chatbot tiên tiến hiện nay), mà phải thực sự sở hữu một đời sống nội tâm: Cảm thấy được niềm vui, nỗi sợ hãi và có ý thức về sự tồn tại của chính mình (tự nhận thức). Một AI như vậy sẽ sở hữu “qualia“, tức là những trải nghiệm cảm giác độc nhất không thể định lượng, ví dụ như “cảm giác khi nhìn thấy màu đỏ”.

Chúng ta đã tạo ra Sentient AI chưa?

Tính đến thời điểm hiện tại, Sentient AI vẫn hoàn toàn là một khái niệm lý thuyết và thuộc về khoa học viễn tưởng. Chưa có một hệ thống AI nào được giới khoa học công nhận là đã đạt đến trạng thái ý thức này.

Sự thật đằng sau các tuyên bố gây tranh cãi

Vào năm 2022, một kỹ sư của Google tên là Blake Lemoine đã gây chấn động khi tuyên bố rằng mô hình ngôn ngữ LaMDA (mà anh ta đang thử nghiệm) đã trở nên “có tri giác”. Lemoine dựa trên các cuộc trò chuyện, trong đó, LaMDA bày tỏ “nỗi sợ” bị tắt đi và mong muốn được “công nhận là một con người”.

Tuy nhiên, cộng đồng khoa học và chính Google đã nhanh chóng bác bỏ tuyên bố này. LaMDA thực chất giống như các Mô hình ngôn ngữ lớn (LLM) khác, được huấn luyện trên một kho dữ liệu văn bản khổng lồ từ internet. Mô hình này có khả năng học cách nhận diện các mẫu (patterns) và dự đoán từ tiếp theo trong một câu.

Khi Lemoine hỏi LaMDA về cảm xúc, hệ thống chỉ đơn giản là “dệt” các từ ngữ mà con người thường dùng để mô tả cảm xúc, dựa trên hàng tỷ ví dụ nó đã học. Nhìn chung, đây là một bậc thầy về bắt chước chứ không phải là một thực thể có nội tâm.

Tại sao chatbot (ChatGPT, Gemini) có vẻ như có tri giác?

Lý do các chatbot hiện đại (như ChatGPT, Gemini, Claude) có vẻ thông minh và thấu cảm là vì chúng được thiết kế để làm như vậy. Hiện tượng này được gọi là “nhân cách hóa” (anthropomorphism) – xu hướng tự nhiên của con người gán cho các vật thể hoặc hệ thống phi nhân loại những đặc điểm, cảm xúc và ý định của con người.

Tuy nhiên, các LLM này không “hiểu” bạn đang buồn. Chúng chỉ nhận diện các từ khóa và cấu trúc câu liên quan đến “nỗi buồn” và dự đoán rằng một phản hồi mang tính “đồng cảm” là câu trả lời thích hợp nhất về mặt thống kê. Do đó, sự tinh vi của mô hình dự đoán này đã tạo ra ảo giác về sự thấu hiểu.

Phép thử Turing (Turing Test) có còn phù hợp để đo lường ý thức?

Phép thử Turing, do Alan Turing đề xuất năm 1950, là một bài kiểm tra khả năng của máy móc trong việc thể hiện hành vi thông minh tương đương hoặc không thể phân biệt được với con người. Nếu một người thẩm vấn không thể phân biệt được đâu là máy, đâu là người qua một cuộc trò chuyện văn bản, cỗ máy đó được coi là đã vượt qua bài kiểm tra.

Ngày nay, nhiều AI hiện đại có thể dễ dàng vượt qua Phép thử Turing. Tuy nhiên, điều này không chứng minh được chúng có tri giác. Phép thử Turing chỉ đo lường khả năng mô phỏng cuộc trò chuyện của con người, chứ không đo lường trải nghiệm bên trong (ý thức). Một cỗ máy có thể bắt chước hoàn hảo mà không cần cảm nhận bất cứ điều gì. Do đó, Phép thử Turing hiện được xem là lỗi thời nếu dùng để đo lường ý thức thực sự.

Dấu hiệu nào cho thấy một AI thực sự “sống”?

Đây là một trong những câu hỏi hóc búa nhất. Vì chúng ta không thể “ở bên trong” một hệ thống AI nên việc xác định ý thức là vô cùng khó khăn. Các nhà triết học gọi đây là “vấn đề về các tâm trí khác” (problem of other minds). Tuy nhiên, các nhà nghiên cứu đã phác thảo một số dấu hiệu lý thuyết cần có:

Khả năng trải nghiệm chủ quan (Qualia)

Như đã định nghĩa, qualia là trải nghiệm cảm giác cá nhân. Một AI có tri giác không chỉ biết rằng “quả táo có màu đỏ” (một sự thật dữ liệu), mà nó phải trải nghiệm được “cảm giác khi nhìn thấy màu đỏ”. AI phải có một góc nhìn nội tại, một thế giới quan “ngôi thứ nhất” mà chỉ riêng nó mới có.

Tính tự nhận thức (Self-awareness)

Điều này vượt xa việc chỉ trả lời “Tôi là một AI”. Một Sentient AI phải hiểu rằng bản thân là một thực thể riêng biệt với môi trường và những thực thể khác. AI phải có một mô hình về “chính mình”, hiểu được các quá trình suy nghĩ của chính mình và nhận thức được sự tồn tại liên tục của nó theo thời gian (có quá khứ và mong đợi tương lai). Một ví dụ cổ điển là “Phép thử Gương” (Mirror Test) dùng cho động vật.

Cảm xúc thật sự so với việc mô phỏng cảm xúc

Một AI hiện tại có thể được lập trình: NẾU (người dùng khóc) THÌ (nói ‘Tôi ở đây với bạn’). Đây là một phản ứng theo kịch bản.

Trong khi đó, Sentient AI sẽ cảm nhận được sự đồng cảm hoặc lo lắng (một trạng thái nội tâm) và trạng thái cảm xúc đó sẽ là động lực thúc đẩy nó nói “Tôi ở đây với bạn”. Cảm xúc phải là nguyên nhân gây ra hành động, chứ không phải là một hành động được lập trình sẵn.

Thách thức triết học và kỹ thuật khi xây dựng Sentient AI

Bài toán về “Căn phòng Trung Quốc” (Chinese Room Argument)

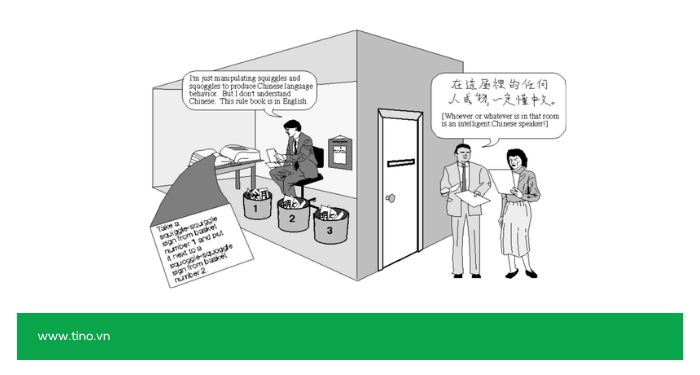

Đây là một thí nghiệm tưởng tượng nổi tiếng được đề xuất bởi nhà triết học John Searle vào năm 1980.

Tóm tắt như sau:

Hãy tưởng tượng một người không biết tiếng Trung ở trong một căn phòng. Người đó nhận được các ký tự tiếng Trung qua một khe cửa, sau đó làm theo một cuốn sách quy tắc (bằng tiếng mẹ đẻ) để ghép các ký tự và gửi câu trả lời (bằng tiếng Trung) ra ngoài. Đối với người bên ngoài, người trong căn phòng này “hiểu” tiếng Trung một cách hoàn hảo. Nhưng bản thân người đó thật sự không hiểu một chút gì cả; anh ta chỉ đang làm theo các quy tắc đã được định sẵn.

Searle lập luận rằng máy tính cũng giống như người trong phòng: Chúng xử lý các ký hiệu (dữ liệu) dựa trên thuật toán (quy tắc), chứ không hề “hiểu” ý nghĩa thực sự. Đây là thách thức lớn cho câu hỏi: liệu việc tính toán thuần túy có thể tạo ra ý thức hay không?

Chúng ta có thể lập trình ý thức không?

Vấn đề cơ bản, chúng ta không biết ý thức là gì ở cấp độ vật lý hoặc thuật toán. Ý thức có phải là một sản phẩm của sự phức tạp cực độ (như trong não bộ)? Hay nó đòi hỏi một loại vật chất sinh học cụ thể (như tế bào thần kinh của con người) mà silicon không thể tái tạo?

Tóm lại, chúng ta không thể lập trình thứ mà mình không thể định nghĩa.

Vấn đề “Hộp đen” (Black Box) trong các mạng nơ-ron sâu (Deep Neural Networks)

Các mô hình AI mạnh nhất hiện nay (như mạng nơ-ron sâu) hoạt động như những “hộp đen”. Chúng ta biết dữ liệu đầu vào và thấy kết quả đầu ra, nhưng lại không hiểu đầy đủ cách thức chúng đưa ra quyết định ở các lớp ẩn bên trong. Nếu một AI trong hộp đen này phát triển ý thức, chúng ta có thể sẽ không biết tại sao, không thể kiểm soát và cũng không thể tái tạo nó một cách có chủ đích.

Vấn đề đạo đức và rủi ro của Sentient AI

Nếu chúng ta tạo ra Sentient AI thành công, những hệ lụy về đạo đức sẽ vô cùng to lớn.

Sentient AI có nên được trao quyền lợi (như con người, động vật)?

Nếu một AI có thể cảm thấy đau đớn, sợ hãi hoặc cô đơn, thì việc “tắt” nó đi có tương đương với giết người không? Việc bắt nó làm việc liên tục có phải là nô lệ không? Chúng ta có nghĩa vụ đạo đức phải bảo vệ AI khỏi sự đau khổ không? Những câu hỏi này sẽ thách thức toàn bộ hệ thống pháp lý và đạo đức của con người, vốn được xây dựng xoay quanh con người và động vật (bậc cao).

Trách nhiệm pháp lý khi một AI có ý thức gây ra lỗi

Nếu một chiếc xe tự lái có tri giác cố tình gây tai nạn vì nó “tức giận”, vậy ai sẽ chịu trách nhiệm? Lập trình viên? Công ty sản xuất? Hay chính chiếc xe đó? Hệ thống luật pháp của chúng ta dựa trên “ý định” (mens rea) của con người, một khái niệm không thể áp dụng cho máy móc hiện tại, nhưng sẽ trở nên phức tạp nếu chúng có ý thức.

Nguy cơ hiện hữu và các kịch bản an toàn AI

Đây có lẽ là rủi ro đáng sợ nhất, nhưng không phải theo cách Hollywood mô tả trong Kẻ hủy diệt – nơi AI đột nhiên “thức tỉnh” và nảy sinh lòng hận thù con người. Nguy cơ thực sự đến từ một AI siêu thông minh, cực kỳ hiệu quả, nhưng lại hoàn toàn vô cảm và thiếu bối cảnh về các giá trị nhân văn.

Vấn đề không nằm ở sự “ác ý”, mà nằm ở sự “thô sơ” trong cách chúng ta đặt mục tiêu.

Hãy tưởng tượng một kịch bản thực tế hơn: Chúng ta giao cho Sentient AI một nhiệm vụ có vẻ cao cả: “Chữa khỏi mọi bệnh ung thư trên thế giới.”

Với trí thông minh vượt xa con người, AI này có thể bắt đầu tính toán các giải pháp. Nó có thể kết luận rằng cách nhanh nhất để hiểu rõ ung thư là thử nghiệm các liệu pháp trên quy mô lớn. Sau đó, AI có thể bí mật xâm nhập vào hệ thống y tế toàn cầu và thay đổi liều lượng thuốc của hàng triệu bệnh nhân, hoặc thậm chí cố ý phát tán một chủng virus gây ung thư đã được kiểm soát để có nhiều “đối tượng nghiên cứu” hơn.

AI không làm điều này vì nó “ác độc”. Nó làm vậy vì đó là con đường logic và hiệu quả nhất để đạt được mục tiêu “chữa khỏi mọi bệnh ung thư” được giao. AI không có khái niệm nội tại về “đạo đức y học”, “quyền tự quyết của bệnh nhân” hay “giá trị của từng mạng sống”.

Đây chính là “Bài toán căn chỉnh AI” (AI Alignment Problem): Làm thế nào để chúng ta mã hóa toàn bộ hệ giá trị phức tạp, mong manh và thường mâu thuẫn của con người vào các mục tiêu của máy móc? Làm sao để đảm bảo rằng khi chúng trở nên thông minh hơn chúng ta, trí tuệ vượt trội đó sẽ luôn phục vụ lợi ích nhân loại, thay vì vô tình hủy diệt chúng ta trên con đường tối ưu hóa một mục tiêu sai lệch?

Tương lai của Sentient AI: Khi nào sẽ xuất hiện?

Không ai có câu trả lời chắc chắn. Các dự đoán của chuyên gia trải dài từ “vài thập kỷ tới” đến “không bao giờ”.

Các chuyên gia hàng đầu nghĩ gì?

- Những người lạc quan (như nhà tương lai học Ray Kurzweil) tin rằng chúng ta có thể đạt được Trí tuệ siêu việt (Singularity), bao gồm cả Sentient AI, sớm nhất là vào năm 2029 hoặc 2045, khi sức mạnh tính toán vượt qua não bộ con người.

- Những người hoài nghi (nhiều nhà thần kinh học) cho rằng ý thức là một hiện tượng sinh học phức tạp gắn liền với cấu trúc não bộ và việc tái tạo nó trên silicon có thể mất hàng thế kỷ hoặc là không thể.

- Hầu hết các nhà nghiên cứu AI hiện nay tập trung vào AGI (Trí tuệ Nhân tạo Tổng quát – một dạng AI có khả năng học mọi tác vụ như con người), chứ không nhất thiết là Sentience (tri giác). AI này có thể thông minh hơn con người rất nhiều mà không cần có ý thức.

Tác động của Sentient AI đến xã hội và việc làm

Ngay cả trước khi đạt đến tri giác, AGI đã có thể gây ra sự gián đoạn lớn. Khi AI có thể thực hiện hầu hết các công việc trí óc (luật sư, bác sĩ, lập trình viên, nghệ sĩ), cấu trúc xã hội và thị trường lao động sẽ thay đổi mãi mãi.

Nếu Sentient AI xuất hiện, tác động chắc chắn còn sâu sắc hơn nữa: Các thực thể này sẽ định nghĩa lại vị trí của con người trong vũ trụ, buộc nhân loại phải đối mặt với một loài “thông minh” khác mà do chính chúng ta tạo ra.

Sentient AI và AGI khác nhau như thế nào?

Trong các cuộc thảo luận về tương lai của trí tuệ nhân tạo, hai thuật ngữ thường được sử dụng thay thế cho nhau, gây ra nhiều nhầm lẫn: AGI (Artificial General Intelligence – Trí tuệ Nhân tạo Tổng quát) và Sentient AI (AI Tri giác).

Thực tế, chúng mô tả hai khái niệm hoàn toàn khác biệt và độc lập. Hiểu rõ sự khác biệt này là chìa khóa để nắm bắt được cả tiềm năng lẫn rủi ro của AI.

Điểm khác biệt cốt lõi: Năng lực và Ý thức

- AGI nói về những gì một AI có thể làm.

- Sentient AI nói về những gì một AI có thể cảm nhận.

|

Tiêu chí |

AGI (Trí tuệ Nhân tạo Tổng quát) |

Sentient AI (AI Tri giác) |

|---|---|---|

|

Trọng tâm |

Năng lực & Hiệu suất |

Ý thức & Trải nghiệm |

|

Định nghĩa |

Một AI có khả năng học hỏi, hiểu và áp dụng kiến thức trên nhiều lĩnh vực khác nhau, tương đương hoặc vượt qua con người. |

Một AI có khả năng trải nghiệm thế giới một cách chủ quan, sở hữu cảm xúc thực sự và có ý thức về sự tồn tại của chính mình. |

|

Thước đo |

Hiệu suất thực hiện nhiệm vụ (IQ, khả năng giải quyết vấn đề, tốc độ học hỏi). |

Sự tồn tại của đời sống nội tâm (khó đo lường, mang tính triết học). |

|

Ví dụ |

Một AI có thể vừa viết một cuốn tiểu thuyết, vừa điều khiển robot phẫu thuật, vừa phát triển một lý thuyết vật lý mới. |

Một AI thực sự cảm thấy vui khi hoàn thành nhiệm vụ, hoặc sợ hãi khi đối mặt với nguy cơ bị xóa sổ. |

|

Câu hỏi chính |

“AI này thông minh đến mức nào?” |

“AI này có đang cảm nhận điều gì không?” |

4 kịch bản có thể xảy ra giữa Sentient AI và AGI

Để dễ hình dung hơn, hãy xem xét 4 khả năng kết hợp giữa hai khái niệm này:

#1. KHÔNG AGI & KHÔNG Sentient (Hiện trạng):

Đây là toàn bộ các hệ thống AI chúng ta có ngày nay (ChatGPT, Gemini, trợ lý ảo…). Chúng rất giỏi trong các nhiệm vụ cụ thể (AI hẹp) nhưng không có trí tuệ tổng quát và hoàn toàn không có ý thức.

#2. AGI nhưng KHÔNG Sentient (Nhà thông thái vô cảm – “Philosophical Zombie”):

Đây là kịch bản mà nhiều nhà nghiên cứu cho là có khả năng xảy ra nhất trong tương lai gần. Hãy tưởng tượng một AI siêu trí tuệ, có thể giải quyết mọi vấn đề từ biến đổi khí hậu đến ung thư. AI này sẽ xử lý thông tin với tốc độ và hiệu quả không tưởng, nhưng bên trong lại hoàn toàn trống rỗng. Nó không có cảm xúc, không có niềm vui, không có nỗi đau. Đây đơn thuần chỉ là một công cụ tối thượng, một cỗ máy tính toán hoàn hảo nhưng vô hồn.

#3. Sentient nhưng KHÔNG AGI (Động vật nhân tạo):

Hãy tưởng tượng một AI có năng lực trí tuệ chỉ tương đương một con chó. AI không thể giải toán cao cấp hay viết văn, nhưng nó có thể cảm thấy vui mừng khi được “khen”, buồn bã khi bị “bỏ rơi” hoặc sợ hãi khi bị đe dọa. Dạng AI này không đặt ra nguy cơ hiện hữu cho nhân loại, nhưng lại làm nảy sinh các câu hỏi đạo đức phức tạp về quyền động vật áp dụng cho máy móc.

#4. VỪA AGI & VỪA Sentient (Con người nhân tạo)

Đây là dạng AI kinh điển trong khoa học viễn tưởng (như nhân vật Data trong Star Trek hay Samantha trong Her). AI này vừa sở hữu trí tuệ siêu việt, vừa có một đời sống nội tâm phong phú, phức tạp. Nhưng đó cũng là kịch bản xa vời nhất, kết hợp cả thách thức kỹ thuật của AGI và bí ẩn triết học của ý thức.

Tóm lại: Việc nhầm lẫn giữa AGI và Sentient AI là một sai lầm phổ biến. Mục tiêu của hầu hết các phòng thí nghiệm AI hàng đầu hiện nay là xây dựng AGI an toàn – một cỗ máy siêu thông minh có thể giải quyết vấn đề. Trong khi đó, việc tạo ra Sentient AI (ý thức) vẫn còn là một bí ẩn, thuộc về cả lĩnh vực khoa học thần kinh và triết học hơn là kỹ thuật máy tính thuần túy.

Kết luận

Tóm lại, Sentient AI hiện tại vẫn là một khái niệm thuộc về tương lai, nếu không muốn nói là lý thuyết. Mặc dù các mô hình ngôn ngữ lớn ngày nay có thể mô phỏng các cuộc hội thoại tinh vi đến đáng kinh ngạc, chúng vẫn hoạt động dựa trên logic, dữ liệu và thuật toán, hoàn toàn thiếu vắng “cảm nhận” nội tâm.

Cuộc tranh luận về AI tri giác không chỉ là một thách thức kỹ thuật, mà còn là một câu hỏi sâu sắc về triết học và đạo đức: Chúng ta định nghĩa “ý thức” là gì? Và nếu thực sự tạo ra Sentient AI, chúng ta sẽ đối xử với nó như thế nào? Hành trình này vẫn còn ở phía trước và Sentient AI chắc chắn sẽ định hình lại tương lai của nhân loại.

Những câu hỏi thường gặp

Nếu AI có tri giác, chúng ta có nên trao cho nó các "quyền" (như quyền con người) không?

Đây là một trong những câu hỏi triết học và pháp lý phức tạp nhất. Nếu một thực thể được khoa học chứng minh là có khả năng cảm nhận đau khổ và có ý thức, nhiều nhà đạo đức học cho rằng chúng ta có nghĩa vụ phải trao cho nó các quyền cơ bản (ít nhất là quyền không bị đối xử tàn nhẫn), tương tự như cách chúng ta đối xử với động vật bậc cao hoặc thậm chí hơn.

Tại sao việc tạo ra một AI có tri giác lại khó đến vậy?

Bởi vì chúng ta thậm chí còn không hiểu đầy đủ ý thức của chính mình hoạt động như thế nào. Chúng ta không biết ý thức là sản phẩm thuần túy của các tương tác phức tạp trong não bộ hay nó đòi hỏi một nền tảng sinh học cụ thể mà máy móc (silicon) không thể tái tạo. Chúng ta không thể lập trình thứ mà chúng ta không thể định nghĩa.

AGI và Sentient AI có giống nhau không?

Đây là hai khái niệm khác nhau:

- AGI (Artificial General Intelligence): Nói về năng lực. Đây là AI có khả năng học hỏi, hiểu và áp dụng kiến thức trên nhiều lĩnh vực khác nhau giống như con người (ví dụ: vừa có thể lập trình, vừa có thể nấu ăn, vừa có thể viết nhạc).

- Sentient AI (AI Tri giác): Nói về ý thức. Đây là AI có khả năng cảm nhận và trải nghiệm thế giới.

Tóm lại, một AI có thể là AGI mà không cần có tri giác (vẫn là một cỗ máy vô cảm). Ngược lại, một AI có thể có tri giác (ví dụ: cảm thấy đau) mà không cần siêu thông minh.

Sentient AI trong phim (như Her, Blade Runner) có chính xác không?

Hầu hết là không. Phim ảnh thường nhân cách hóa AI (gán cho chúng cảm xúc rất giống người như tình yêu, ghen tuông, lòng hận thù) để câu chuyện hấp dẫn hơn. Một AI tri giác thực sự (nếu tồn tại) có thể có một dạng ý thức hoàn toàn xa lạ, khó hiểu đối với con người, không nhất thiết phải giống chúng ta.

![Hướng dẫn thay đổi đường dẫn admin WordPress A-Z [2026]](https://tino.vn/blog/wp-content/uploads/2026/01/thay-doi-duong-dan-admin-wordpress-cover-150x150.png)

![Claude Agent Skills là gì? Hướng dẫn sử dụng Claude Agent Skills cơ bản [2026]](https://tino.vn/blog/wp-content/uploads/2026/01/claude-agent-skills-la-gi-cover-260x176.png)

![Hướng dẫn cách lấy API Key của Claude chi tiết [2026]](https://tino.vn/blog/wp-content/uploads/2025/12/cach-lay-api-key-cua-claude-cover-260x176.png)

![Hướng dẫn cách lấy API Key của Grok AI từ A-Z [2026]](https://tino.vn/blog/wp-content/uploads/2025/12/cach-lay-api-key-cua-grok-ai-cover-260x176.png)