Trong kỷ nguyên Big Data, dữ liệu không chỉ lớn mà còn phức tạp, đòi hỏi các quy trình xử lý phải chạy liên tục và chính xác. Nhưng điều gì xảy ra khi một tác vụ thất bại lúc 3 giờ sáng? Làm thế nào để bạn quản lý hàng trăm quy trình ETL phụ thuộc lẫn nhau mà không lãng phí sức người? Đây chính là lúc Airflow xuất hiện. Vậy cụ thể Airflow là gì? Cùng Tino giải mã chi tiết qua bài viết dưới đây nhé!

Airflow là gì?

Tổng quan về Airflow

Airflow (Apache Airflow) là một nền tảng mã nguồn mở được sử dụng để lập trình, lên lịch và giám sát các quy trình công việc một cách có hệ thống. Được phát triển tại Airbnb, Airflow nhanh chóng trở thành một dự án hàng đầu của Quỹ phần mềm Apache (Apache Software Foundation) và là công cụ không thể thiếu trong lĩnh vực Kỹ thuật dữ liệu (Data Engineering).

Chức năng cốt lõi của Airflow là điều phối, đóng vai trò như một “nhạc trưởng” thông minh, đảm bảo rằng các tác vụ phức tạp được thực thi đúng thứ tự, vào đúng thời điểm, và xử lý các sự cố có thể xảy ra.

Điểm khác biệt chính của Airflow nằm ở triết lý “Workflows as Code” (Quy trình làm việc dưới dạng mã). Thay vì sử dụng giao diện kéo-thả, người dùng định nghĩa toàn bộ quy trình làm việc của mình bằng ngôn ngữ lập trình Python. Điều này mang lại sự linh hoạt vô hạn, cho phép các kỹ sư xây dựng các pipeline phức tạp, tích hợp logic động và quản lý phiên bản cho các quy trình dữ liệu của họ giống như cách họ quản lý mã nguồn phần mềm.

Ngày nay, Airflow được sử dụng rộng rãi bởi các công ty công nghệ lớn như Airbnb, Spotify, Netflix hay Uber để tự động hóa hàng nghìn tác vụ mỗi ngày. Nhờ khả năng mở rộng, tính minh bạch và cộng đồng phát triển mạnh mẽ, Apache Airflow đã trở thành chuẩn mực trong lĩnh vực Data Engineering hiện đại.

Tại sao Cronjob là không đủ?

Trong giai đoạn đầu khi xây dựng hệ thống dữ liệu hoặc ứng dụng nhỏ, nhiều kỹ sư thường sử dụng Cronjob để tự động hóa các tác vụ theo lịch định sẵn. Ví dụ: “chạy một script xóa file log lúc 3 giờ sáng mỗi ngày” hoặc “gửi một email báo cáo lúc 8 giờ sáng”.

Nhìn chung, Cronjob đơn giản, dễ thiết lập và phù hợp với các tác vụ độc lập, nhỏ lẻ. Tuy nhiên, quy mô và độ phức tạp tăng lên, Cronjob nhanh chóng bộc lộ nhiều hạn chế nghiêm trọng:

Thiếu khả năng quản lý luồng công việc phức tạp

Cronjob chỉ đơn thuần chạy một tập lệnh theo lịch, không hiểu mối quan hệ giữa các tác vụ. Trong khi ở thực tế, các quy trình dữ liệu thường phụ thuộc lẫn nhau – ví dụ: bạn chỉ có thể xử lý dữ liệu sau khi quá trình thu thập hoàn tất và chỉ có thể gửi báo cáo khi dữ liệu đã được tổng hợp.

Cronjob không thể quản lý chuỗi phụ thuộc này, dẫn đến việc xử lý sai thứ tự, chồng lệnh hoặc lỗi dữ liệu nếu một bước bị thất bại mà hệ thống vẫn tiếp tục chạy.

Không có khả năng giám sát và khôi phục lỗi

Cronjob không cung cấp giao diện để theo dõi trạng thái tác vụ. Khi một job thất bại, bạn chỉ biết thông qua log hệ thống – điều này khiến việc kiểm tra thủ công rất tốn thời gian.

Khó mở rộng và thiếu tính linh hoạt

Cronjob hoạt động tốt trên một máy chủ đơn, nhưng khi hệ thống cần mở rộng sang nhiều server hoặc môi trường cloud, việc đồng bộ và quản lý Cronjob trở nên phức tạp.

Không hỗ trợ theo dõi phụ thuộc dữ liệu

Cronjob không có cơ chế để đảm bảo rằng dữ liệu đầu vào đã sẵn sàng trước khi chạy job. Điều này đặc biệt nguy hiểm trong các pipeline dữ liệu lớn, nơi một sai sót nhỏ có thể làm hỏng toàn bộ kết quả.

Khó bảo trì và mở rộng quy trình theo thời gian

Khi số lượng Cronjob tăng lên hàng chục hoặc hàng trăm, việc bảo trì, cập nhật hoặc thay đổi logic trở thành “ác mộng”. Các script nằm rải rác, thiếu cấu trúc, và không thể dễ dàng tái sử dụng.

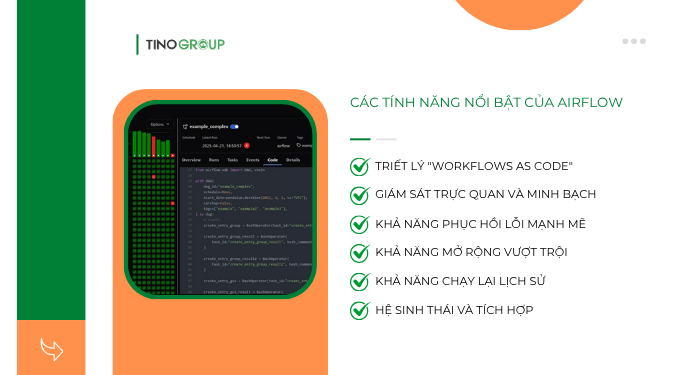

Các tính năng nổi bật của Airflow

Triết lý “Workflows as Code”

Thay vì dùng giao diện kéo – thả bị giới hạn, bạn định nghĩa toàn bộ quy trình công việc bằng Python. Điều này mở ra vô số khả năng:

- Quản lý phiên bản: Bạn có thể đưa các pipeline của mình vào Git. Điều này cho phép bạn theo dõi lịch sử thay đổi (ai, khi nào, tại sao), xem xét code (code reviews), và dễ dàng hoàn tác (rollback) khi có lỗi.

- Tạo Pipeline động: Bạn có thể dùng code Python để tự động tạo ra hàng trăm pipeline giống nhau từ một tệp cấu hình, thay vì tạo thủ công.

- Dễ kiểm thử: Vì pipeline là code, bạn có thể viết các bài kiểm thử (unit tests) cho chúng, đảm bảo logic nghiệp vụ chính xác trước khi triển khai.

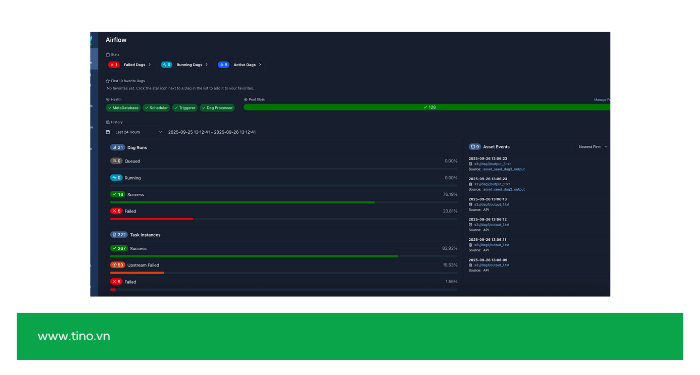

Giám sát trực quan và minh bạch

Airflow thay thế “hộp đen” của các script Cronjob bằng một Giao diện Người dùng (UI) mạnh mẽ, nơi bạn có thể:

- Theo dõi thời gian thực: Trực quan hóa trạng thái của mọi DAG và mọi Task (đang chạy, thành công, thất bại, đang chờ thử lại).

- Xem log tập trung: Đọc log lỗi của bất kỳ task nào ngay trên UI mà không cần phải SSH vào nhiều máy chủ để tìm file log.

- Hiểu rõ sự phụ thuộc: Xem biểu đồ và cấu trúc cây để hiểu rõ task nào phải chạy trước, task nào chạy sau.

Khả năng phục hồi lỗi mạnh mẽ

Trong thực tế, các quy trình dữ liệu rất “mong manh” (mạng lỗi, API sập, dữ liệu đến trễ). Airflow được thiết kế với tâm thế chấp nhận thất bại và xử lý chúng một cách thông minh:

- Tự động thử lại: Tự động chạy lại các task thất bại theo số lần và khoảng thời gian chờ bạn định nghĩa (ví dụ: “thử lại 3 lần, mỗi lần cách nhau 5 phút”).

- Cảnh báo tự động: Tích hợp sẵn cơ chế gửi email hoặc tin nhắn (qua Slack, Teams) khi một task quan trọng thất bại vĩnh viễn.

Khả năng mở rộng vượt trội

Airflow có thể phát triển từ việc chạy vài tác vụ trên máy tính cá nhân của bạn lên đến điều phối hàng chục ngàn tác vụ phức tạp mỗi ngày trên một cụm máy chủ:

Với kiến trúc phân tán, Airflow có thể được thiết lập để phân phối công việc (tasks) cho một “hạm đội” các máy trạm (Workers) thông qua các Executor như Celery hoặc Kubernetes, đảm bảo hệ thống không bị quá tải.

Khả năng chạy lại lịch sử

Nếu bạn phát hiện một lỗi logic trong code và cần xử lý lại dữ liệu của 2 tuần qua, Airflow cho phép bạn làm điều này một cách dễ dàng. Bạn chỉ cần ra lệnh cho Airflow “chạy lại” (backfill) các DAG trong khoảng thời gian đó, và nó sẽ tự động lập lịch và thực thi lại mọi thứ theo đúng thứ tự.

Hệ sinh thái và tích hợp

Airflow là một dự án mã nguồn mở hàng đầu với một cộng đồng khổng lồ. Lợi ích là bạn có một thư viện “Provider” (nhà cung cấp) khổng lồ, cung cấp các Operator được xây dựng sẵn để kết nối và điều khiển gần như mọi dịch vụ bên ngoài (AWS S3, Google BigQuery, Snowflake, Databricks, Spark,…), giúp bạn tiết kiệm vô số thời gian tích hợp.

Khám phá các thành phần cốt lõi và nguyên lý hoạt động của Airflow

3 khái niệm cốt lõi trong Airflow

Đây là những khối xây dựng bạn sử dụng trong tệp Python để định nghĩa quy trình:

1. DAG (Directed Acyclic Graph):

Đây là “bản thiết kế” cho quy trình làm việc (workflow) của bạn. Nó là một tệp Python định nghĩa:

- Tập hợp các Task bạn muốn chạy.

- Mối quan hệ phụ thuộc giữa chúng (ví dụ: Task B chỉ chạy sau Task A).

- Lịch trình chạy (ví dụ: chạy hàng ngày lúc 3 giờ sáng).

2. Operators (Toán tử):

Đây là các “khối xây dựng” (building blocks) định nghĩa một công việc cụ thể phải làm. Khi bạn thêm một Operator vào DAG, bạn đang tạo ra một Task. Ví dụ phổ biến:

- BashOperator: Chạy một lệnh shell (ví dụ: echo ‘hello’).

- PythonOperator: Chạy một hàm Python.

- PostgresOperator: Chạy một truy vấn SQL trên Postgres.

- …Operator: Có hàng trăm Operator để tương tác với AWS, Google Cloud, Snowflake, v.v.

3. Task (Nhiệm vụ):

Một Task là một bản thể hiện (instance) của một Operator. Nó là một nút (node) trong DAG, đại diện cho một đơn vị công việc cần được thực thi.

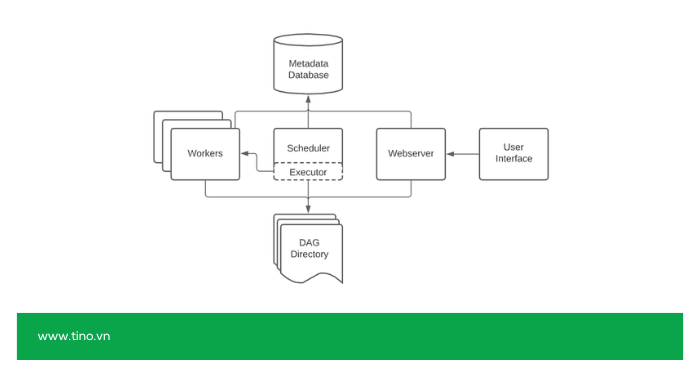

5 thành phần kiến trúc hệ thống

Dưới đây là 4 dịch vụ chính chạy liên tục để Airflow của bạn hoạt động:

1. Scheduler (Bộ lập lịch):

Scheduler là một dịch vụ chạy liên tục, có các nhiệm vụ chính bao gồm:

- Quét thư mục chứa các tệp DAG của bạn để phát hiện thay đổi.

- Kiểm tra lịch trình (schedule) của tất cả các DAG.

- Khi đến thời điểm chạy, nó sẽ tạo một bản thể hiện (instance) của DAG (gọi là DagRun).

- Theo dõi sự phụ thuộc của các Task (nhiệm vụ).

- Gửi các Task sẵn sàng thực thi (đã đủ điều kiện) vào hàng đợi.

2. Web Server (Máy chủ Web):

Web Server cung cấp giao diện người dùng (UI) trực quan mà bạn tương tác. Thông qua UI, bạn có thể:

- Giám sát trạng thái của các DAG và Task (thành công, thất bại, đang chạy).

- Kích hoạt (trigger) hoặc hủy bỏ một DAG chạy bằng tay.

- Xem log lỗi chi tiết của từng Task.

- Quản lý các kết nối, biến và người dùng.

3. Metadata Database (Cơ sở dữ liệu Siêu dữ liệu):

Metadata Database lưu trữ mọi trạng thái và thông tin về hệ thống của bạn (thường dùng Postgres hoặc MySQL). Cơ sở dữ liệu này có thể lưu trữ:

- Tất cả các DAG và cấu trúc của chúng.

- Lịch sử của tất cả các lần chạy (DagRun).

- Trạng thái của từng Task (task instances).

- Các biến, kết nối (connections) đến hệ thống bên ngoài, và thông tin người dùng.

- (Lưu ý: Scheduler, Web Server và Workers đều giao tiếp qua cơ sở dữ liệu này).

4. Executor (Bộ thực thi):

Executor là cơ chế chịu trách nhiệm chạy các Task. Khi Scheduler quyết định một Task cần chạy, nó sẽ đưa cho Executor:

- LocalExecutor: Chạy các Task song song trên cùng một máy chủ nơi Scheduler đang chạy (dùng cho quy mô nhỏ).

- CeleryExecutor / KubernetesExecutor: Phân phối các Task đến một cụm (cluster) gồm nhiều máy trạm (Workers). Đây là cách Airflow mở rộng quy mô (scalability) để chạy hàng ngàn Task cùng lúc.

5. Worker (máy chạm):

Worker là các máy chạm đảm nhiệm chạy các tác vụ được giao trong Executor. Trong mô hình phân tán, bạn có thể có nhiều Worker hoạt động song song, giúp hệ thống xử lý hàng nghìn công việc mỗi phút.

Nếu một Worker bị lỗi, các Worker khác có thể tự động tiếp quản nhiệm vụ, đảm bảo quy trình không bị gián đoạn.

Nguyên lý hoạt động tổng thể của Airflow

Quá trình hoạt động cơ bản của Airflow có thể tóm tắt theo chu trình sau:

- Scheduler đọc các DAG định nghĩa bằng Python và lên lịch thực thi dựa trên thời gian được cấu hình.

- Khi đến thời điểm, Scheduler sẽ gửi task vào Executor.

- Executor phân phối task đến các Worker phù hợp để thực thi.

- Kết quả và log được ghi lại trong Metadata Database.

- Người dùng có thể theo dõi toàn bộ tiến trình qua Web Server UI.

Nhờ mô hình này, Airflow có thể điều phối hàng nghìn workflow đồng thời, đảm bảo mỗi tác vụ được chạy đúng thời điểm, đúng thứ tự và có thể phục hồi nếu xảy ra lỗi.

Tại sao doanh nghiệp nên sử dụng Airflow?

- Thúc đẩy chuyển đổi số và ra quyết định nhanh hơn: Airflow giúp tự động hóa toàn bộ quy trình xử lý dữ liệu – từ thu thập, làm sạch, tổng hợp đến phân tích. Nhờ đó, doanh nghiệp có thể cập nhật dữ liệu theo thời gian thực và ra quyết định nhanh, chính xác hơn, thay vì phải tổng hợp thủ công.

- Chuẩn hóa và minh bạch hóa quy trình dữ liệu: Airflow hợp nhất các tác vụ dữ liệu rải rác trong nhiều hệ thống thành một nền tảng thống nhất, giúp ghi log, theo dõi và kiểm soát dễ dàng. Điều này đảm bảo tính minh bạch, truy xuất nguồn dữ liệu rõ ràng và đáp ứng yêu cầu tuân thủ, bảo mật.

- Giảm thiểu sai sót và rủi ro con người: Với khả năng tự động hóa pipeline và kiểm soát điều kiện chạy, Airflow loại bỏ lỗi thao tác thủ công. Cơ chế retry và cảnh báo thông minh giúp phát hiện, xử lý lỗi sớm, tránh gián đoạn toàn hệ thống.

- Linh hoạt mở rộng theo quy mô doanh nghiệp: Airflow dễ dàng mở rộng từ một máy chủ nhỏ đến hạ tầng phân tán hoặc cloud-native. Nhờ kiến trúc mô-đun (Scheduler – Worker – Executor), doanh nghiệp có thể tích hợp với AWS, GCP, Kubernetes mà không cần thay đổi quy trình.

- Hợp nhất toàn bộ hệ sinh thái dữ liệu: Airflow đóng vai trò “trung tâm điều phối”, kết nối cơ sở dữ liệu, API, kho dữ liệu và công cụ phân tích thành một luồng thống nhất. Điều này giúp dữ liệu luân chuyển liền mạch giữa các bộ phận và hệ thống.

- Tiết kiệm chi phí vận hành và nhân sự: Tự động hóa giúp giảm đáng kể khối lượng công việc thủ công, tiết kiệm chi phí vận hành và thời gian của đội kỹ thuật. Nhân sự có thể tập trung vào các nhiệm vụ tạo giá trị cao hơn như tối ưu dữ liệu hay phát triển sản phẩm.

- Bảo mật và kiểm soát dữ liệu nội bộ tuyệt đối: Khi triển khai trên môi trường riêng, Airflow giúp doanh nghiệp kiểm soát hoàn toàn dữ liệu và khóa API, đảm bảo an toàn cho các lĩnh vực đòi hỏi bảo mật cao như tài chính, y tế hay thương mại điện tử.

So sánh nhanh Airflow với các công cụ khác

Airflow vs. Prefect

Đây là cuộc chiến giữa “sự ổn định” và “tính linh hoạt hiện đại”.

- Airflow (đặc biệt là các phiên bản cũ hơn) có cấu trúc khá cứng nhắc. Bạn phải định nghĩa các DAG (pipeline) theo một cách cụ thể. Bù lại, hệ sinh thái Provider (kết nối) của nó là lớn nhất, cho phép bạn tích hợp với gần như mọi dịch vụ.

- Prefect được xây dựng với triết lý “Python-native”. Bạn chỉ cần thêm các “decorator” (@task, @flow) vào các hàm Python bình thường để biến chúng thành một workflow. Điều này khiến Prefect cực kỳ linh hoạt để tạo các pipeline động (dynamic pipeline) – thứ mà Airflow làm khá vất vả. Prefect cũng xử lý các luồng công việc thất bại và chạy lại (retry) một cách thông minh hơn.

➡️ Dùng Airflow cho các hệ thống ETL/ELT lớn, đã được chuẩn hóa, cần nhiều tích hợp. Dùng Prefect khi đội ngũ của bạn mạnh về Python và cần chạy các workflow phức tạp, thay đổi liên tục (ví dụ: pipeline Machine Learning).

Airflow vs. Dagster

Đây là sự khác biệt về triết lý: “Chạy tác vụ” so với “Tạo tài sản”.

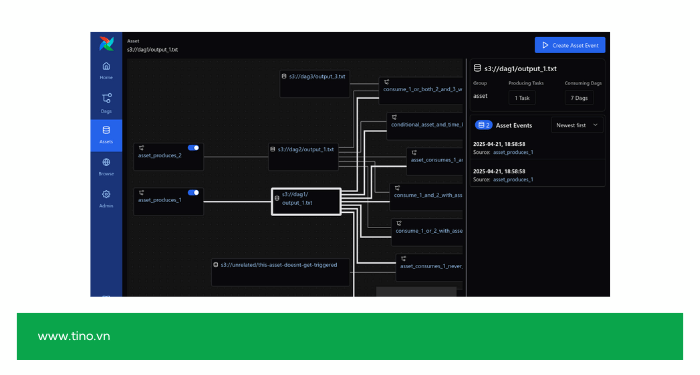

- Airflow tập trung vào Tác vụ (Tasks). Công cụ sẽ quan tâm: “Task A đã chạy thành công chưa? OK, chạy Task B.” Dagster không thực sự “hiểu” Task A đã tạo ra cái gì.

- Dagster tập trung vào Tài sản Dữ liệu (Data Assets). Công cụ này quan tâm: “Task A tạo ra file_raw.csv. Task B cần file_raw.csv để tạo ra bảng_clean_data.” Dagster theo dõi toàn bộ dòng đời (lineage) của dữ liệu và cho phép bạn kiểm thử chất lượng dữ liệu ngay trong pipeline.

➡️ Dùng Airflow khi bạn chủ yếu cần chạy các quy trình. Dùng Dagster khi bạn muốn quản lý và đảm bảo chất lượng của chính dữ liệu đầu ra (ví dụ: kiểm thử dữ liệu, theo dõi nguồn gốc dữ liệu).

Airflow vs. Luigi

Đây là cuộc chiến giữa một “nền tảng toàn diện” và một “thư viện chuyên dụng”.

- Luigi (được tạo bởi Spotify) rất giỏi trong việc quản lý các pipeline phụ thuộc phức tạp. Triết lý của Luigi là “target-based”: một task chỉ chạy nếu “mục tiêu” (target) của nó (ví dụ: một file trên S3, một bảng trong database) chưa tồn tại. Nó đơn giản, nhẹ và tập trung.

- Airflow là một nền tảng hoàn chỉnh hơn nhiều. Công cụ này có Scheduler, Web Server (UI), và cơ sở dữ liệu riêng. Giao diện UI của Airflow vượt trội so với Luigi, cho phép giám sát, chạy lại (backfill) và quản lý tốt hơn. Airflow cũng xử lý việc lập lịch (scheduling) tốt hơn, trong khi Luigi chủ yếu tập trung vào việc giải quyết sự phụ thuộc.

➡️ Dùng Luigi cho các dự án ETL chuyên sâu, nặng về xử lý batch, nơi bạn chỉ quan tâm đến việc file đầu ra đã tồn tại hay chưa. Dùng Airflow khi bạn cần một hệ thống hoàn chỉnh để lập lịch, giám sát, và quản lý hàng trăm pipeline khác nhau.

Khi nào nên (và không nên) sử dụng Airflow?

Khi nào NÊN sử dụng Airflow?

- Bạn có các quy trình (pipelines) phức tạp và phụ thuộc lẫn nhau: Bạn có các tác vụ phải chạy theo một trật tự nghiêm ngặt (Task A -> Task B -> Task C). Hoặc phức tạp hơn: Task A phải chạy xong, sau đó Task B và C chạy song song, và chỉ khi cả B và C hoàn tất, Task D mới được bắt đầu.

- Bạn cần xử lý lỗi một cách thông minh (Tự động thử lại): Bạn muốn hệ thống tự động chạy lại một tác vụ bị lỗi (ví dụ: do API sập, mạng lag) 3 lần, mỗi lần cách nhau 10 phút, trước khi nó “bỏ cuộc” và gửi cảnh báo. Cron không thể làm điều này.

- Bạn cần giám sát, cảnh báo và xem log tập trung: Bạn muốn một giao diện (UI) duy nhất để xem chính xác tác vụ nào đã thất bại lúc 3 giờ sáng, đọc log lỗi của nó, và biết được lý do. Airflow cung cấp một trung tâm chỉ huy, thay vì phải kiểm tra log trên 10 máy chủ khác nhau.

- Bạn cần chạy lại dữ liệu lịch sử (Backfilling): Bạn phát hiện một lỗi logic trong code và cần xử lý lại toàn bộ dữ liệu của 2 tuần qua. Airflow cho phép bạn dễ dàng ra lệnh “chạy lại quy trình này cho khoảng ngày X đến Y”, và nó sẽ tự động chạy 14 lần (cho 14 ngày) một cách chính xác.

- Quy trình của bạn được “lập lịch” (Scheduled) và chạy theo “batch”: Quy trình của bạn chạy theo một lịch trình cố định (ví dụ: mỗi giờ, mỗi ngày, mỗi tuần). Airflow là vua của xử lý batch.

- Bạn muốn quản lý “Workflows as Code”: Bạn muốn lưu trữ logic pipeline của mình trong Git, thực hiện code review, và quản lý phiên bản giống như bạn làm với phần mềm.

Khi nào KHÔNG NÊN sử dụng Airflow?

- Tác vụ đơn giản, không có phụ thuộc phức tạp: Ví dụ chỉ cần chạy một script mỗi ngày, Cronjob hoặc các công cụ lập lịch nhẹ hơn (như Prefect, Dagster Lite) sẽ hiệu quả hơn.

- Hệ thống nhỏ hoặc không có đội ngũ kỹ thuật chuyên sâu: Airflow cần cấu hình, giám sát và bảo trì định kỳ. Việc này có thể tốn công nếu hạ tầng nhỏ.

- Cần xử lý dữ liệu theo thời gian thực (real-time): Airflow được thiết kế cho batch processing (xử lý theo lô), không phù hợp với các tác vụ stream liên tục như Kafka hay Flink.

- Môi trường giới hạn tài nguyên: Việc vận hành Airflow yêu cầu tài nguyên CPU, RAM và lưu trữ log đáng kể, nên không lý tưởng cho VPS yếu hoặc chi phí thấp.

Hướng dẫn cách cài đặt Airflow với Docker

Phần này giả định bạn đã cài đặt sẵn Docker và Docker Compose trên máy của mình.

Bước 1: Tải tệp docker-compose.yaml chính thức

Apache Airflow cung cấp một tệp cấu hình docker-compose.yaml cực kỳ đầy đủ. Bạn chỉ cần tải về:

curl -LfO "https://airflow.apache.org/docs/apache-airflow/latest/docker-compose.yaml"Bước 2: Chuẩn bị môi trường

Trước khi khởi chạy, bạn cần tạo các thư mục mà docker-compose.yaml mong đợi. Các thư mục này sẽ được “map” (ánh xạ) vào bên trong container, cho phép bạn chỉnh sửa file DAG ở máy thật của mình.

mkdir ./dags ./logs ./pluginsTiếp theo, bạn cần tạo một file .env để khai báo AIRFLOW_UID. Điều này để tránh các vấn đề về “permission” (quyền truy cập file) giữa máy chủ của bạn và container:

echo -e "AIRFLOW_UID=$(id -u)" > .envBước 3: Khởi tạo cơ sở dữ liệu

Airflow cần một cơ sở dữ liệu (Metadata Database) để lưu trữ trạng thái của các DAG, các lần chạy,… Tệp compose này sử dụng Postgres.

Lệnh sau sẽ chạy một service tên là airflow-init để thiết lập cơ sở dữ liệu và tạo user admin mặc định.

docker-compose up airflow-initBước 4: Khởi động Airflow!

Sau khi quá trình “init” hoàn tất, giờ bạn đã có thể khởi động toàn bộ hệ thống (Scheduler, Webserver, Worker, …).

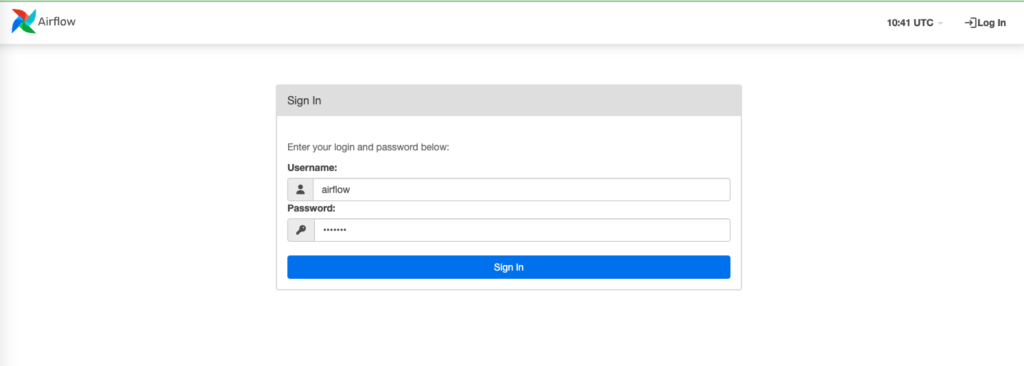

docker-compose up -dBước 5: Truy cập giao diện Airflow

Chờ khoảng 1-2 phút để các service khởi động hoàn toàn. Sau đó, mở trình duyệt của bạn và truy cập:

- URL: http://localhost:8080

- Username: airflow

- Password: airflow

Nếu bạn thấy giao diện đăng nhập, bạn đã cài đặt thành công!

Kết luận

Dù bạn là một Data Engineer đang vật lộn với các pipeline ETL, một Data Scientist muốn tự động hóa mô hình của mình, hay một DevOps muốn quản lý các tác vụ hệ thống, việc hiểu rõ Airflow sẽ mở ra cơ hội tối ưu hóa toàn bộ quy trình xử lý dữ liệu trong tổ chức.

Những câu hỏi thường gặp

DAG (Directed Acyclic Graph) là gì?

DAG (Đồ thị có hướng không tuần hoàn) là một tệp Python, định nghĩa tất cả các tác vụ (tasks) trong quy trình của bạn, thứ tự chúng chạy và lịch trình chạy.

Sự khác biệt cơ bản nhất giữa Airflow và Cron (Cronjob) là gì?

Cron chỉ là một bộ hẹn giờ đơn giản (fire-and-forget – “bắn và quên”). Airflow là một nền tảng điều phối (orchestration) hoàn chỉnh, có khả năng quản lý các phụ thuộc phức tạp (Task B chờ Task A), tự động thử lại (retry), và cung cấp giao diện giám sát trực quan.

Airflow có phải là công cụ xử lý dữ liệu như Apache Spark không?

Không. Airflow là công cụ điều phối, có chức năng ra lệnh cho các công cụ khác (như Spark) làm việc. Airflow quản lý quy trình, còn Spark thực thi việc xử lý dữ liệu lớn.

Airflow có thể xử lý dữ liệu streaming (thời gian thực) như Kafka hay Flink không?

Không. Airflow là một nền tảng xử lý theo lô (batch), dựa trên lịch trình (ví dụ: chạy hàng giờ, hàng phút). Công cụ này không được thiết kế để xử lý dữ liệu streaming (thời gian thực). Để làm việc đó, bạn nên dùng Kafka, Flink, hoặc Spark Streaming.

"Backfilling" trong Airflow nghĩa là gì và khi nào nên dùng?

“Backfilling” là hành động chạy lại các quy trình (DAGs) cho một khoảng thời gian trong quá khứ. Cơ chế này rất hữu ích khi bạn vừa sửa một lỗi logic trong code và cần xử lý lại dữ liệu của 10 ngày trước; Airflow sẽ tự động chạy lại 10 lần cho 10 ngày đó.

Apache Airflow có miễn phí không?

Có. Apache Airflow là một dự án mã nguồn mở 100% (theo giấy phép Apache 2.0) và hoàn toàn miễn phí. Bạn chỉ phải trả chi phí cho hạ tầng (máy chủ, cloud) để chạy nó.

![Cursor là gì? Hướng dẫn tải, đăng ký và sử dụng Cursor miễn phí [2026]](https://tino.vn/blog/wp-content/uploads/2026/01/cursor-la-gi-cover-150x150.png)

![Google Stitch là gì? Hướng dẫn sử dụng Google Stitch chi tiết [2026]](https://tino.vn/blog/wp-content/uploads/2026/01/google-stitch-la-gi-cover-150x150.png)

![Github Copilot là gì? Cách sử dụng GitHub Copilot miễn phí [2026]](https://tino.vn/blog/wp-content/uploads/2026/01/github-copilot-la-gi-cover-150x150.png)

![Khám phá 10+ plugin SEO WordPress tốt nhất [2026]](https://tino.vn/blog/wp-content/uploads/2026/01/plugin-seo-wordpress-cover-150x150.png)