Trong khi thế giới công nghệ vẫn đang tập trung vào cuộc đua “tam mã” giữa OpenAI, Google Gemini và Anthropic (Claude), một “thế lực” từ phương Đông đang trỗi dậy với tốc độ đáng kinh ngạc. Alibaba Cloud không chỉ tham gia vào cuộc chơi AI, họ đang định “viết lại” luật chơi bằng hệ sinh thái Qwen (Tongyi Qianwen). Cùng Tino khám phá các model của Qwen AI qua bài viết dưới đây nhé!

Điều gì giúp Qwen nổi bật giữa cuộc đua của các ông lớn AI?

Chiến lược “Song kiếm hợp bích”: Open-Weight và Độc quyền

Đây là điểm độc đáo nhất của Qwen. Họ không chọn một trong hai, họ làm cả hai.

Alibaba liên tục phát hành các mô hình Qwen2 (như Qwen2-72B) với trọng số mở (giấy phép Apache 2.0). Các mô hình này cực kỳ mạnh, thường xuyên đứng đầu các bảng xếp hạng mô hình nguồn mở, cạnh tranh trực tiếp và thậm chí vượt mặt Llama 3 của Meta. Điều này giúp họ xây dựng một cộng đồng developer khổng lồ.

Song song đó, họ giữ lại các mô hình mạnh nhất (như Qwen3-Max và Qwen2.5-Max) làm mô hình độc quyền, bán qua API trên Alibaba Cloud. Những mô hình này được tạo ra để cạnh tranh sòng phẳng với GPT-4o, Claude 3.5 Sonnet và Gemini 1.5 Ultra.

Chiến lược này giúp Qwen vừa thu hút cộng đồng (như Llama) vừa có sản phẩm thương mại đỉnh cao (như OpenAI).

Tốc độ tiến hóa và chuyên biệt hóa đáng kinh ngạc

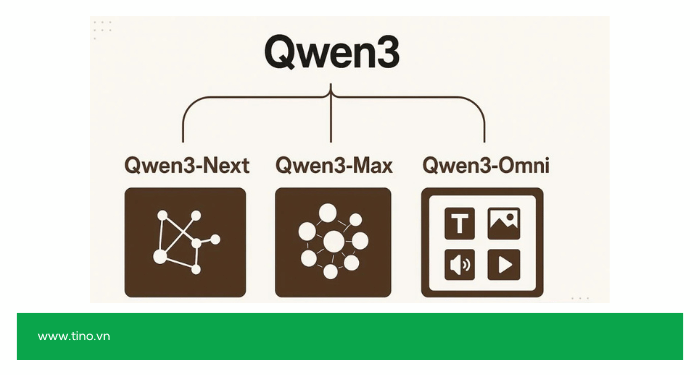

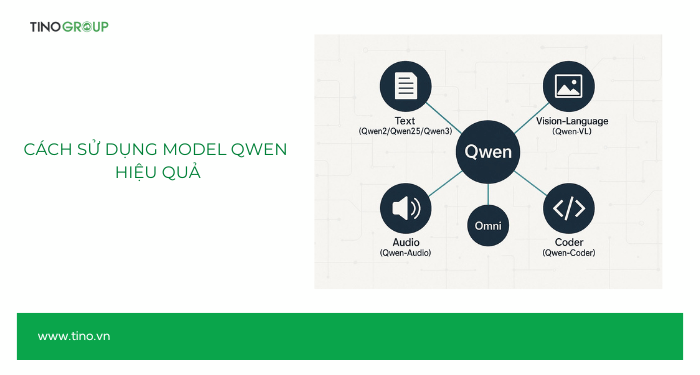

Qwen không phải là một mô hình, mà là một hệ sinh thái (ecosystem) khổng lồ đang tiến hóa hàng tháng:

- Tốc độ lặp lại (Iteration): Tốc độ ra mắt phiên bản mới của Qwen (từ Qwen1.5, Qwen2, Qwen2.5 đến Qwen3) nhanh hơn đáng kể so với các đối thủ.

- Mô hình Đa phương thức (Multimodal) toàn diện: Họ có Qwen-VL (Visual Language) để “nhìn”, Qwen-Audio để “nghe” và xử lý âm thanh, và đỉnh cao là Qwen-Omni (như Qwen3-Omni) có thể xử lý đồng thời văn bản, hình ảnh, video và âm thanh trong thời gian thực, tương tự như GPT-4o.

- Mô hình chuyên dụng: Họ tạo ra các phiên bản chuyên biệt cho từng tác vụ cụ thể như Qwen-Coder (viết code), Qwen-Math (giải toán).

Tham vọng dẫn đầu rõ rệt

Qwen không chỉ “theo sau”. Họ đang chủ động tạo ra các mô hình để cạnh tranh ở cấp độ cao nhất và thậm chí là các khái niệm “tin đồn”:

- Cạnh tranh SOTA: Các mô hình của họ (cả mở và đóng) liên tục được so sánh và tuyên bố vượt qua các mô hình SOTA (State-of-the-art) như GPT-4o hay Claude 3.5 trên nhiều benchmark.

- Mô hình lý luận (Reasoning): Đáng chú ý nhất là việc họ phát hành QwQ (Qwen with Questions), một mô hình lý luận chuyên sâu. Động thái này được coi là bước đi trực tiếp để cạnh tranh với các khái niệm mô hình lý luận tiên tiến như “o1” của OpenAI.

Xem thêm: Qwen AI là gì?

Tổng hợp các dòng model của Qwen AI

Dòng model ngôn ngữ lõi (Core Language)

Đây là các model nền tảng, tập trung vào xử lý văn bản, với nhiều kích cỡ (parameter) khác nhau, thường được phát hành theo thế hệ.

- Qwen1.5 (Tháng 2/2024): Thế hệ model nền tảng, bao gồm các kích cỡ từ 0.5B đến 72B và một phiên bản MoE (Mixture-of-Experts) là Qwen1.5-MoE-A2.7B.

- Qwen2 (Tháng 6/2024): Một bản nâng cấp lớn về hiệu suất, vượt trội Llama 3 trên nhiều benchmark. Nổi bật nhất là Qwen2-72B-Instruct.

- Qwen2.5 (Tháng 9/2024): Bổ sung các kích cỡ 3B, 14B và 32B.

- Qwen3 (Tháng 4/2025): Thế hệ thứ ba, hỗ trợ hai chế độ:

- Instruct (Non-Thinking): Chế độ hướng dẫn, phản hồi nhanh.

- Thinking: Chế độ lý luận, suy nghĩ từng bước trước khi trả lời.

- Các model tiêu biểu: Qwen3-4B, Qwen3-8B, Qwen3-30B-A3B, và model MoE mã nguồn mở cực lớn Qwen3-235B-A22B.

- Qwen3-Next (Tháng 9/2025): Một kiến trúc model mới, tập trung vào hiệu suất training và inference vượt trội, đặc biệt cho context dài.

Dòng model đa phương thức (Multimodal)

Các model này có khả năng “nhìn” (hình ảnh, video) và “nghe” (âm thanh).

- Qwen-VL: Dòng model thị giác-ngôn ngữ (Vision-Language) đầu tiên.

- Các phiên bản: Qwen-VL, Qwen2-VL, Qwen2.5-VL.

- Qwen3-VL (Tháng 9/2025): Phiên bản VL mạnh nhất, với các biến thể lớn như Qwen3-VL-235B-A22B, có khả năng hiểu và lý luận sâu trên hình ảnh.

- Qwen-Audio: Dòng model chuyên xử lý âm thanh và giọng nói.

- Các phiên bản: Qwen-Audio, Qwen2-Audio.

- Qwen-Omni (Đa phương thức Toàn diện):

- Qwen2.5-Omni (Tháng 3/2025): Model “all-in-one” có thể xử lý đồng thời văn bản, hình ảnh, video và âm thanh.

- Qwen3-Omni (Tháng 9/2025): Thế hệ kế nhiệm, tăng cường khả năng streaming đa phương thức thời gian thực.

- Qwen3-LiveTranslate (Tháng 9/2025): Một model chuyên biệt, có thể là nhánh của Omni, tập trung vào dịch thuật đa phương thức (audio và video) thời gian thực.

Dòng model chuyên biệt

Đây là các model được tối ưu hóa sâu cho một tác vụ cụ thể, thường là các tác vụ khó nhất.

- Lý luận (Reasoning):

- QwQ-32B (Tháng 3/2025): Model lý luận chuyên sâu (open-weight) được thiết kế để cạnh tranh trực tiếp với các mô hình như o1-mini của OpenAI và DeepSeek-R1.

- Viết code (Coding):

- Các phiên bản: Qwen2.5-Coder, Qwen3-Coder (Tháng 7/2025).

- Qwen3-Coder-480B-A35B-Instruct: Một model MoE khổng lồ chuyên về agentic coding (tác tử code) và hiểu biết quy mô repository.

- Toán học (Math):

- Qwen2-Math: Model được tinh chỉnh đặc biệt cho logic và giải toán.

- An toàn (Safety):

- Qwen3Guard (Tháng 9/2025): Model “guardrail” (rào chắn) đầu tiên của Qwen, được tinh chỉnh để phân loại và đảm bảo an toàn cho đầu vào/đầu ra.

Dòng model Flagship (Độc quyền)

Đây là các model mạnh nhất, cạnh tranh nhất, thường được giữ kín (closed-source) và cung cấp qua API thương mại của Alibaba Cloud.

- Qwen2.5-Max (Tháng 1/2025): Model flagship tại thời điểm ra mắt, được tuyên bố vượt mặt GPT-4o.

- Qwen3-Max (Tháng 9/2025): Model flagship kế nhiệm, là model lớn nhất và mạnh nhất của Qwen cho đến nay.

Các ứng dụng phổ biến của model Qwen

Ứng dụng doanh nghiệp và sáng tạo nội dung

(Chủ yếu sử dụng các model ngôn ngữ lõi như Qwen2, Qwen3)

- Chatbot và trợ lý ảo: Xây dựng các trợ lý dịch vụ khách hàng thông minh, có khả năng đối thoại tự nhiên, hiểu ngữ cảnh và xử lý các yêu cầu phức tạp.

- Sáng tạo nội dung tự động: Viết bài đăng blog chuẩn SEO, kịch bản video, email marketing, mô tả sản phẩm và nội dung quảng cáo.

- Tóm tắt và phân tích văn bản: Tự động tóm tắt các báo cáo dài, tài liệu pháp lý hoặc các cuộc họp. Phân tích cảm xúc (sentiment analysis) từ phản hồi của khách hàng.

- Dịch thuật nâng cao: Dịch thuật tài liệu và giao tiếp đa ngôn ngữ với độ chính xác cao (Qwen3 được đào tạo trên hơn 119 ngôn ngữ).

Ứng dụng đa phương thức (Hình ảnh, âm thanh, video)

(Sử dụng các model Qwen-VL, Qwen-Audio, Qwen-Omni)

- Phân tích hình ảnh và video (Qwen-VL):

- Thương mại điện tử: Tự động tạo mô tả sản phẩm từ hình ảnh.

- Bảo mật: Nhận diện và phân tích các đối tượng hoặc hành vi bất thường trong camera an ninh.

- Hỗ trợ người khiếm thị: “Đọc” và mô tả thế giới xung quanh qua hình ảnh.

- Xử lý âm thanh và giọng nói (Qwen-Audio):

- Gỡ băng cuộc họp: Chuyển đổi file ghi âm (speech-to-text) thành văn bản với độ chính xác cao.

- Tổng hợp giọng nói (TTS): Tạo ra giọng nói AI tự nhiên cho sách nói, video hoặc trợ lý ảo.

- Trợ lý đa giác quan (Qwen-Omni):

- Chatbot tương tác toàn diện: Người dùng có thể vừa nói, vừa gửi hình ảnh hoặc video để ra lệnh (ví dụ: “Món đồ trong ảnh này là gì và tôi có thể mua nó ở đâu?”).

- Dịch thuật thời gian thực (Qwen3-LiveTranslate): Dịch trực tiếp các cuộc gọi video hoặc hội nghị, xử lý cả âm thanh và hình ảnh (ví dụ: dịch khẩu hình hoặc văn bản trên slide).

Ứng dụng kỹ thuật và chuyên sâu

(Sử dụng các model Qwen-Coder, Qwen-Math, QwQ, Qwen3-Thinking)

- Phát triển phần mềm (Qwen-Coder):

- Viết code (Code Generation): Tự động sinh ra các đoạn code hoặc toàn bộ hàm dựa trên mô tả bằng ngôn ngữ tự nhiên.

- Gỡ lỗi (Debugging): Phân tích code, tìm lỗi và đề xuất cách sửa chữa.

- Tác tử code (Agentic Coding): Các agent AI tự động lập kế hoạch, viết, kiểm thử và chạy code để hoàn thành một dự án phần mềm.

- Giáo dục và nghiên cứu (Qwen-Math):

- Tạo ra các “gia sư AI” có khả năng giải thích và giải các bài toán logic, toán học phức tạp từng bước một.

- Giải quyết vấn đề phức tạp (QwQ, Qwen3-Thinking):

- Phân tích chiến lược: Sử dụng khả năng lý luận (reasoning) để phân tích các kịch bản kinh doanh, tài chính hoặc pháp lý phức tạp.

- Tối ưu hóa quy trình: Giúp các hệ thống tự động đưa ra quyết định thông minh hơn dựa trên nhiều yếu tố.

- Kiểm soát an toàn AI (Qwen3Guard):

- Tích hợp vào các ứng dụng AI khác để làm “rào chắn”, phát hiện và ngăn chặn các nội dung độc hại, đảm bảo AI hoạt động an toàn.

Cách sử dụng model Qwen hiệu quả

Chọn đúng model cho đúng tác vụ

Đây là bước quan trọng nhất vì Qwen là một “họ” model, không phải một model đơn lẻ. Sử dụng sai model sẽ gây lãng phí tài nguyên (nếu dùng model quá lớn) hoặc cho ra kết quả kém (nếu dùng model quá nhỏ/sai chuyên môn).

- Tác vụ cơ bản (Chat, Viết lách, Sáng tạo):

- Hiệu quả nhất: Qwen2-72B-Instruct (phiên bản open-weight). Đây là model cực kỳ mạnh, cân bằng giữa tốc độ, chi phí (nếu tự host) và hiệu suất, thường xuyên vượt mặt Llama 3 70B.

- Tốt nhất (API): Qwen3-Max (phiên bản độc quyền). Sử dụng khi bạn cần chất lượng tối đa, không ngại chi phí API, cạnh tranh trực tiếp với GPT-4o.

- Tác vụ Lập trình (Viết code, Gỡ lỗi):

- Chuyên dụng: Qwen3-Coder. Model này được đào tạo chuyên sâu về code, có khả năng hiểu các repository lớn, vượt trội hơn các model thông thường (như Qwen2-Instruct) trong các tác vụ coding.

- Tác vụ Phân tích Hình ảnh/Video (Multimodal):

- Chuyên dụng: Qwen-VL (ví dụ: Qwen3-VL). Sử dụng khi bạn cần model “nhìn” và hiểu nội dung hình ảnh.

- Toàn diện nhất: Qwen-Omni (ví dụ: Qwen3-Omni). Sử dụng khi bạn cần xử lý nhiều loại input cùng lúc (ví dụ: nói chuyện, gửi ảnh và video trong cùng một cuộc hội thoại).

- Tác vụ Lý luận Phức tạp (Toán học, Logic):

- Chuyên dụng (Open-Weight): QwQ-32B. Model này được thiết kế đặc biệt để “suy nghĩ” từng bước, chuyên trị các bài toán logic khó.

- Model Lõi (Kích hoạt chế độ): Qwen3 (các phiên bản) khi bật chế độ “Thinking”.

Kỹ thuật Prompting Hiệu quả

Cách bạn “ra lệnh” sẽ quyết định 80% chất lượng đầu ra.

- Sử dụng chế độ “Thinking” (với Qwen3): Đây là tính năng đặc biệt của Qwen3. Khi gặp một câu hỏi phức tạp (ví dụ: “Lập kế hoạch marketing cho sản phẩm X”), thay vì trả lời ngay, bạn có thể yêu cầu nó “suy nghĩ”.

- Cách làm: Thêm các cụm từ như “Hãy suy nghĩ từng bước một” (Think step-by-step), “Lập luận lý do của bạn”, hoặc “Phân tích vấn đề trước khi trả lời”.

- Lợi ích: Model sẽ tạo ra một chuỗi lý luận (chain-of-thought) trước, giúp câu trả lời cuối cùng chính xác và sâu sắc hơn.

- Prompting đa phương thức (với Qwen-VL/Omni): Khi làm việc với hình ảnh hoặc âm thanh, prompt của bạn phải rõ ràng về mối quan hệ giữa các input.

- Ví dụ kém: Gửi 1 ảnh, 1 audio và hỏi “Cái gì đây?”

- Ví dụ tốt: [Audio of a cat] “Mô tả hình ảnh và cho biết âm thanh này có phải của con vật trong ảnh không?”

- Kỹ thuật “Role-Playing” (Đóng vai): Luôn cho model một vai trò cụ thể. Điều này giúp định hình phong cách và kiến thức của nó.

- Ví dụ: “Bạn là một chuyên gia lập trình Python với 20 năm kinh nghiệm. Tối ưu đoạn code sau…” thay vì chỉ nói “Tối ưu code này”.

- Cung cấp ngữ cảnh (Context) và ví dụ (Few-shot): Đừng bắt model “đoán”. Nếu bạn muốn nó viết theo một định dạng cụ thể, hãy cho nó 1-2 ví dụ mẫu.

- Ví dụ: “Tôi muốn bạn phân loại phản hồi của khách hàng thành Tích cực, Tiêu cực, Trung tính. Đây là ví dụ:\n1. ‘Sản phẩm tuyệt vời!’ -> Tích cực\n2. ‘Giao hàng hơi chậm.’ -> Trung tính\nBây giờ hãy phân loại: ‘Tôi không thích màu này.'”

Tối ưu về kỹ thuật (Cho bản Open-Weight)

Nếu bạn tự triển khai các model Qwen (thay vì dùng API), đây là các cách để sử dụng hiệu quả:

- Quantization (Lượng tử hóa): Không phải ai cũng có GPU A100/H100. Để chạy các model lớn như Qwen2-72B trên phần cứng yếu hơn (ví dụ: RTX 4090 hoặc thậm chí CPU/Macbook), hãy sử dụng các phiên bản đã được lượng tử hóa (như 4-bit, 8-bit, GGUF, AWQ).

- Lợi ích: Giảm đáng kể dung lượng VRAM và tăng tốc độ inference, trong khi chỉ hy sinh một chút độ chính xác.

- Fine-Tuning (Tinh chỉnh): Model Qwen gốc rất giỏi, nhưng nó không biết gì về dữ liệu nội bộ của công ty bạn.

- Cách làm: Lấy model nền (như Qwen2-72B) và “đào tạo thêm” (fine-tune) trên dữ liệu của riêng bạn (ví dụ: các ticket hỗ trợ khách hàng, tài liệu kỹ thuật nội bộ).

- Lợi ích: Bạn sẽ có một model “chuyên gia” về lĩnh vực của mình với chi phí thấp hơn nhiều so với đào tạo từ đầu.

- Quản lý Context (Context Length): Các model mới (như Qwen3-Next) hỗ trợ context rất dài. Tuy nhiên, sử dụng context càng dài thì càng tốn tài nguyên và chậm.

- Mẹo: Chỉ cung cấp lượng thông tin (context) vừa đủ cho tác vụ. Nếu bạn đang làm RAG (Retrieval-Augmented Generation), hãy tối ưu hệ thống tìm kiếm (vector search) để chỉ lấy các đoạn văn bản liên quan nhất, thay vì “nhồi” toàn bộ tài liệu vào prompt.

Kết luận

Hệ sinh thái Qwen AI không còn là một “ngôi sao đang lên” mà đã thực sự trở thành một “chòm sao” sáng chói trên bản đồ AI toàn cầu. Với chiến lược “open-source” mạnh mẽ, tốc độ cập nhật chóng mặt và sự đầu tư nghiêm túc vào các mô hình, Alibaba đã chứng minh rằng họ không chỉ sao chép mà còn đang tích cực đổi mới. Cuộc đua AI chắc chắn sẽ không phải là đường đua của riêng ai và Qwen đã khẳng định mình là một tay đua chủ chốt không thể bị xem thường. Bạn đã sẵn sàng để trải nghiệm sức mạnh của chúng chưa?

Những câu hỏi thường gặp

Model Qwen nào mạnh nhất hiện nay?

Model độc quyền flagship mạnh nhất là Qwen3-Max. Đây là model lớn nhất và có hiệu năng cao nhất của Alibaba, được thiết kế để cạnh tranh trực tiếp với các model SOTA (state-of-the-art) hàng đầu thế giới.

Chế độ "Thinking" (Suy nghĩ) của Qwen3 là gì?

Đây là một tính năng đặc biệt của dòng Qwen3. Khi được kích hoạt (thường bằng một prompt cụ thể), model sẽ thực hiện một chuỗi lý luận “chain-of-thought” (suy nghĩ từng bước) trước khi đưa ra câu trả lời cuối cùng. Điều này giúp tăng độ chính xác đáng kể cho các câu hỏi phức tạp và đòi hỏi logic.

Model open-weight nào của Qwen tốt nhất để tự host?

Hiện tại, Qwen2-72B-Instruct được coi là một trong những model open-weight mạnh mẽ và cân bằng nhất, thường xuyên đứng đầu các bảng xếp hạng, vượt qua cả Llama 3 70B trong nhiều tác vụ.

Qwen có thể hiểu hình ảnh, âm thanh và video không?

Có. Qwen có các dòng model đa phương thức chuyên dụng, bao gồm Qwen-VL (hiểu hình ảnh) và Qwen-Audio (hiểu âm thanh). Model cao cấp nhất là Qwen-Omni (ví dụ: Qwen3-Omni) có thể xử lý đồng thời văn bản, hình ảnh, âm thanh và video trong cùng một yêu cầu.

![Hướng dẫn thay đổi đường dẫn admin WordPress A-Z [2026]](https://tino.vn/blog/wp-content/uploads/2026/01/thay-doi-duong-dan-admin-wordpress-cover-150x150.png)

![Claude Agent Skills là gì? Hướng dẫn sử dụng Claude Agent Skills cơ bản [2026]](https://tino.vn/blog/wp-content/uploads/2026/01/claude-agent-skills-la-gi-cover-260x176.png)

![Hướng dẫn cách lấy API Key của Claude chi tiết [2026]](https://tino.vn/blog/wp-content/uploads/2025/12/cach-lay-api-key-cua-claude-cover-260x176.png)

![Hướng dẫn cách lấy API Key của Grok AI từ A-Z [2026]](https://tino.vn/blog/wp-content/uploads/2025/12/cach-lay-api-key-cua-grok-ai-cover-260x176.png)