Dù doanh nghiệp có thể ứng dụng AI vào quy trình vận hành nhưng vẫn gặp phải một thách thức, đó là thiếu dữ liệu cập nhật theo thời gian thực hoặc thiếu kiến thức chuyên sâu về doanh nghiệp. Để giải quyết vấn đề nan giải này, kỹ thuật RAG đã ra đời và trở thành chìa khóa vàng giúp AI ‘thông minh’ và chính xác hơn. Tuy nhiên, việc triển khai RAG thường đòi hỏi kỹ năng lập trình phức tạp. Đây cũng chính là lúc n8n phát huy sức mạnh. Vậy RAG là gì? Cùng Tino tìm hiểu cách ứng dụng RAG trong n8n qua bài viết dưới đây nhé!

Tổng quan về RAG

RAG là gì?

RAG (viết tắt của Retrieval-Augmented Generation) là một kỹ thuật tối ưu hóa trong lĩnh vực trí tuệ nhân tạo, được thiết kế nhằm nâng cao độ chính xác và tính tin cậy của các mô hình ngôn ngữ lớn (LLM). Phương pháp này hoạt động bằng cách cho phép mô hình tham chiếu đến các nguồn dữ liệu bên ngoài (như tài liệu nội bộ, cơ sở dữ liệu vector hoặc thông tin trực tuyến) trước khi tạo ra phản hồi cho người dùng.

Thay vì chỉ dựa hoàn toàn vào kho kiến thức tĩnh đã được huấn luyện từ trước – vốn thường bị giới hạn về thời gian cập nhật và thiếu tính chuyên sâu – quy trình RAG sẽ truy xuất các đoạn thông tin liên quan nhất và cung cấp chúng làm ngữ cảnh đầu vào cho AI.

Nhờ cơ chế kết hợp chặt chẽ giữa khả năng tìm kiếm dữ liệu và năng lực sinh văn bản tự nhiên, giải pháp này giúp khắc phục hiệu quả hiện tượng “ảo giác” thông tin, đồng thời đảm bảo câu trả lời luôn sát với bối cảnh thực tế của doanh nghiệp mà không cần tốn kém chi phí để tái huấn luyện mô hình.

Cơ chế hoạt động cốt lõi của RAG

Quy trình vận hành của kỹ thuật RAG không quá phức tạp nhưng lại mang đến hiệu quả vượt trội nhờ sự phối hợp nhịp nhàng giữa ba giai đoạn chính: Truy xuất (Retrieval), Tăng cường (Augmentation) và Tạo sinh (Generation).

Đầu tiên, toàn bộ dữ liệu nguồn (tài liệu, văn bản, thông tin sản phẩm) sẽ được chuyển đổi thành các vectơ số học (embeddings) và lưu trữ trong một cơ sở dữ liệu vectơ chuyên dụng. Khi người dùng gửi một câu hỏi hoặc yêu cầu, hệ thống sẽ thực hiện chuyển đổi câu lệnh đó thành vectơ tương ứng và quét qua cơ sở dữ liệu để tìm kiếm những đoạn thông tin có nội dung hoặc ngữ nghĩa tương đồng nhất.

Tiếp theo, ở giai đoạn tăng cường, các đoạn thông tin vừa tìm được sẽ được ghép nối với câu hỏi gốc của người dùng để tạo thành một ngữ cảnh đầu vào đầy đủ và chi tiết.

Cuối cùng, mô hình ngôn ngữ lớn (LLM) sẽ tiếp nhận toàn bộ khối thông tin đã được làm giàu này. Thay vì phải tự suy diễn dựa trên dữ liệu huấn luyện cũ, AI sẽ sử dụng ngữ cảnh được cung cấp để tổng hợp và soạn thảo câu trả lời chính xác, sát thực tế và phù hợp nhất với nhu cầu của người hỏi.

Tại sao RAG lại quan trọng đối với doanh nghiệp hiện nay?

Trong kỷ nguyên số, dữ liệu được xem là tài sản quý giá nhất của mọi tổ chức. Việc ứng dụng RAG đang trở thành xu hướng tất yếu vì những giá trị thiết thực mà giải pháp này mang lại cho doanh nghiệp:

- Đảm bảo tính chính xác và cập nhật: Các mô hình AI truyền thống thường bị giới hạn bởi thời điểm kết thúc huấn luyện, dẫn đến việc thiếu hụt thông tin mới nhất. RAG cho phép hệ thống truy cập vào dữ liệu thời gian thực hoặc tài liệu nội bộ vừa được cập nhật, giúp loại bỏ tình trạng cung cấp thông tin lỗi thời.

- Khắc phục hiện tượng “ảo giác” của AI: Một trong những rủi ro lớn nhất khi dùng AI là việc mô hình tự bịa đặt thông tin khi không biết câu trả lời. Bằng cách buộc AI phải dựa trên nguồn dữ liệu được cung cấp để phản hồi, kỹ thuật RAG giúp giảm thiểu tối đa rủi ro sai lệch thông tin, tăng độ tin cậy cho các ứng dụng chăm sóc khách hàng hay tư vấn tự động.

- Tối ưu hóa chi phí và nguồn lực: Việc huấn luyện lại (Fine-tuning) một mô hình ngôn ngữ lớn để học thêm kiến thức mới thường tốn kém rất nhiều chi phí tính toán và thời gian. Ngược lại, việc cập nhật cơ sở dữ liệu cho hệ thống RAG diễn ra nhanh chóng, đơn giản và tiết kiệm chi phí hơn nhiều.

- Bảo mật dữ liệu nội bộ: Doanh nghiệp có thể tận dụng sức mạnh ngôn ngữ của các mô hình AI công cộng để xử lý dữ liệu riêng tư mà không cần phải lo lắng về việc dữ liệu nhạy cảm bị rò rỉ hay bị sử dụng để huấn luyện ngược lại cho mô hình gốc, do quyền kiểm soát dữ liệu truy xuất hoàn toàn nằm trong tay doanh nghiệp.

Vai trò của n8n trong việc triển khai RAG

Trong hệ sinh thái các công cụ tự động hóa, n8n nổi lên như một nền tảng ưu việt giúp đơn giản hóa quá trình xây dựng các ứng dụng AI phức tạp. Đối với việc triển khai kỹ thuật RAG, n8n đóng vai trò là “trung tâm điều phối”, kết nối linh hoạt giữa các nguồn dữ liệu, cơ sở dữ liệu lưu trữ và mô hình ngôn ngữ lớn.

Thay vì phải viết hàng trăm dòng mã lệnh bằng Python hay JavaScript để tích hợp các thư viện như LangChain, người dùng n8n có thể thực hiện toàn bộ quy trình thông qua giao diện kéo thả trực quan. Nền tảng này cung cấp sẵn các nút chức năng (nodes) chuyên dụng cho AI, cho phép thiết lập luồng xử lý dữ liệu từ khâu thu thập, mã hóa (embedding) đến khâu truy xuất và tạo câu trả lời chỉ trong thời gian ngắn.

Ngoài ra, n8n mang lại sự linh hoạt tối đa cho hệ thống. Người quản trị có thể dễ dàng thay đổi nhà cung cấp mô hình AI (ví dụ: chuyển từ OpenAI sang Anthropic hoặc các mô hình Local LLM) mà không làm gián đoạn quy trình vận hành. Khả năng tùy biến cao giúp doanh nghiệp kiểm soát chặt chẽ luồng dữ liệu, đảm bảo tính bảo mật và tối ưu hóa chi phí vận hành cho từng tác vụ cụ thể.

Các thành phần cần thiết để xây dựng RAG trong n8n

Để thiết lập một quy trình RAG hoàn chỉnh và hiệu quả trên n8n, người dùng cần chuẩn bị và cấu hình 4 thành phần kỹ thuật cốt lõi sau đây:

Mô hình ngôn ngữ lớn (Chat Model)

Đây là bộ não của toàn bộ hệ thống, chịu trách nhiệm tiếp nhận thông tin và sinh ra câu trả lời tự nhiên. Trong n8n, thành phần này thường được kết nối thông qua các node như OpenAI Chat Model, Gemini Chat Model, Anthropic Chat Model (Claude) hoặc Ollama Chat Model (dành cho các mô hình chạy cục bộ). Việc lựa chọn mô hình nào sẽ phụ thuộc vào yêu cầu về độ thông minh, tốc độ phản hồi và ngân sách của dự án.

Cơ sở dữ liệu Vector

Thành phần này đóng vai trò là kho lưu trữ kiến thức dài hạn cho AI. Dữ liệu văn bản sau khi được xử lý sẽ được lưu tại đây dưới dạng các dãy số (vectơ). n8n hỗ trợ tích hợp với nhiều nhà cung cấp Vector Store phổ biến như Pinecone, Qdrant, Supabase hoặc Weaviate. Vector Store đảm nhiệm chức năng tìm kiếm và truy xuất nhanh chóng các đoạn thông tin có ý nghĩa tương đồng với câu hỏi của người dùng.

Mô hình Embeddings

Để máy tính có thể hiểu và so sánh được sự tương đồng giữa các văn bản, dữ liệu cần phải được chuyển đổi thành dạng số học. Mô hình Embeddings thực hiện nhiệm vụ chuyển đổi văn bản đầu vào (câu hỏi và tài liệu) thành các vectơ. Trong n8n, người dùng cần kết nối thành phần này (thường dùng chung nhà cung cấp với Chat Model như OpenAI Embeddings) vào cả hai quy trình: nạp dữ liệu vào kho và truy vấn dữ liệu ra.

Công cụ tải và xử lý dữ liệu

Trước khi đưa vào lưu trữ, dữ liệu thô cần được xử lý sơ bộ.

- Document Loader: Các node này giúp n8n đọc được nội dung từ nhiều định dạng khác nhau như tệp PDF, Google Docs, Notion hoặc nội dung trang web.

- Text Splitter: Vì các mô hình AI có giới hạn về độ dài đầu vào, công cụ chia nhỏ văn bản (Text Splitter) sẽ cắt tài liệu lớn thành các đoạn nhỏ (chunks) để đảm bảo việc tìm kiếm diễn ra chính xác và hiệu quả hơn.

So sánh RAG và MCP

Trong khi RAG tập trung vào việc “đọc và trả lời” dựa trên dữ liệu, MCP tập trung vào việc chuẩn hóa cách AI “kết nối và hành động” với các hệ thống bên ngoài.

Bảng so sánh nhanh RAG vs MCP:

Tiêu chí RAG (Retrieval-Augmented Generation) MCP (Model Context Protocol) Mục tiêu chính Truy xuất thông tin để trả lời câu hỏi chính xác hơn. Chuẩn hóa kết nối để AI thực hiện hành động hoặc dùng công cụ. Loại dữ liệu Dữ liệu phi cấu trúc (PDF, Docx, Text) hoặc bán cấu trúc. Dữ liệu cấu trúc, API, Database, và các công cụ hệ thống. Cơ chế hoạt động Tìm kiếm đoạn văn bản tương đồng -> Gửi kèm ngữ cảnh cho AI -> AI sinh câu trả lời. Thiết lập giao thức chuẩn (Client-Host-Server) để AI gọi hàm (Function Calling) hoặc thao tác trên ứng dụng khác. Tính chất Thụ động (Chỉ đọc và tổng hợp thông tin). Chủ động (Có thể ghi, sửa, xóa hoặc kích hoạt quy trình). Ví dụ điển hình Chatbot hỏi đáp về quy định nhân sự nội bộ. Trợ lý AI tự động kiểm tra lịch, đặt phòng họp và gửi email xác nhận. Hình tượng Như một Thủ thư: Tra cứu sách để tìm thông tin bạn cần. Như cổng USB-C: Một chuẩn kết nối duy nhất cho mọi thiết bị ngoại vi (chuột, phím, ổ cứng).

Mối quan hệ tương hỗ

Hai công nghệ này không loại trừ nhau mà thường kết hợp để tạo ra các “AI Agent” mạnh mẽ:

- RAG giải quyết vấn đề “Biết”: Cung cấp kiến thức nền tảng chính xác.

- MCP giải quyết vấn đề “Làm”: Cung cấp khả năng thao tác.

Ví dụ: Một hệ thống chăm sóc khách hàng có thể dùng RAG để tra cứu chính sách bảo hành (tìm thông tin), sau đó dùng MCP để truy cập hệ thống CRM và tạo phiếu bảo hành cho khách (thực hiện hành động).

Khi nào nên dùng công nghệ nào?

- Chọn RAG khi: Nhu cầu chính là tra cứu, tóm tắt tài liệu, giải đáp thắc mắc dựa trên kho tri thức tĩnh.

- Chọn MCP khi: Cần tích hợp AI với nhiều hệ thống phần mềm khác nhau để tự động hóa quy trình hoặc khi cần chuẩn hóa cách các AI Agent giao tiếp với nhau.

Xem thêm: MCP là gì? Hướng dẫn cài đặt & sử dụng MCP trong n8n chi tiết

Hướng dẫn cách tạo RAG trên n8n (sử dụng mẫu có sẵn đơn giản)

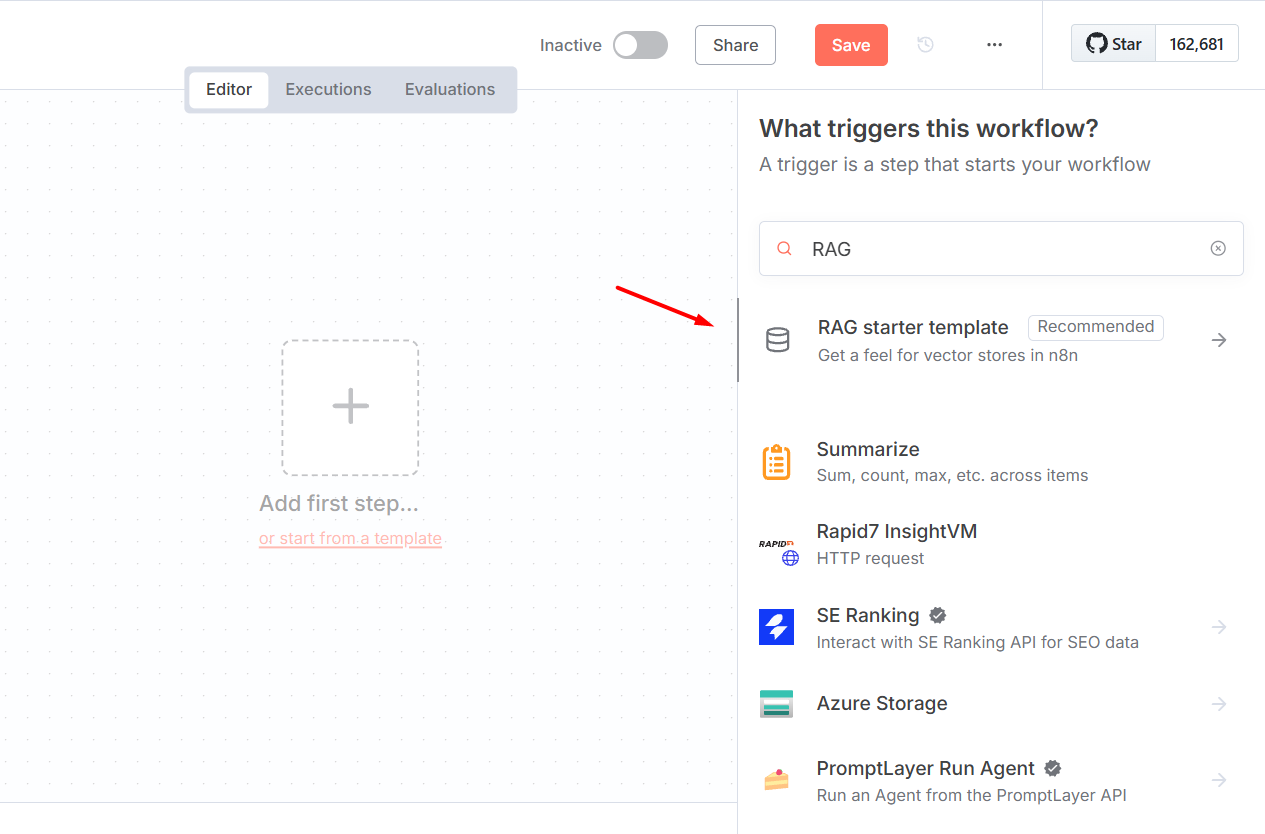

Khởi tạo từ mẫu “RAG starter template”

Bước 1: Tại giao diện tạo workflow mới, hãy tìm kiếm từ khóa “RAG” trong thanh công cụ bên phải.

Bước 2: Chọn “RAG starter template”. Bạn sẽ được chuyển sang một tab mới với workflow đã được thiết lập sẵn các node cần thiết, giúp tiết kiệm thời gian thiết lập thủ công.

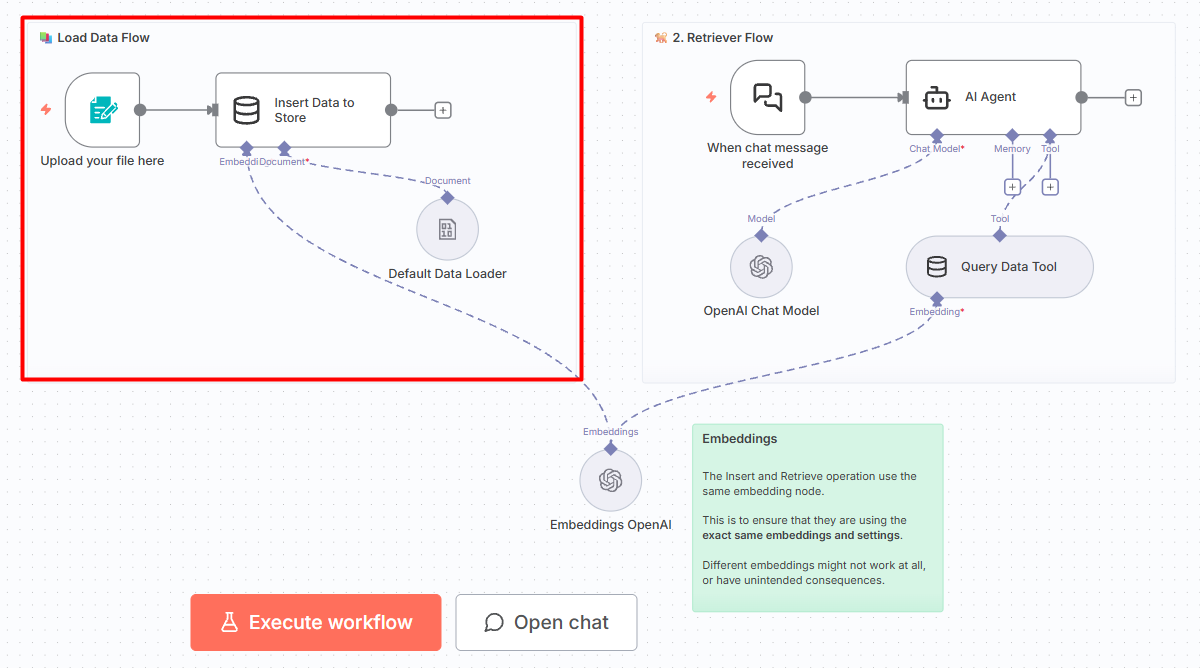

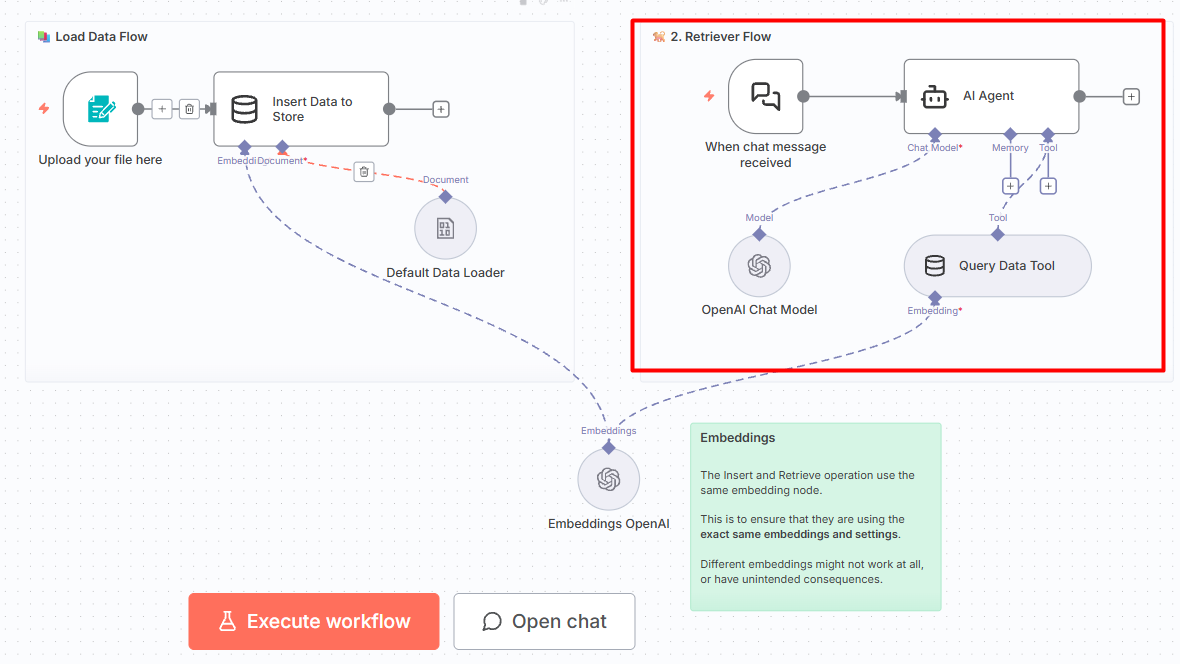

Giải thích chi tiết cấu trúc Workflow

Luồng nạp dữ liệu (Load Data Flow)

Luồng này thực hiện chức năng tiếp nhận tệp tin từ người dùng và lưu trữ vào bộ nhớ ngắn hạn (In-Memory) để phục vụ cho phiên làm việc hiện tại.

Node n8n Form Trigger:

Đây là cổng tiếp nhận dữ liệu đầu vào. Người dùng sẽ tải tệp tin (PDF, Docx, Text) lên thông qua một giao diện biểu mẫu web (Form). Tệp tin nhị phân sau đó được chuyển trực tiếp đến node xử lý tiếp theo.

Node Simple Vector Store:

Đây là node quan trọng nhất trong luồng nạp dữ liệu.

- Chức năng: Đóng vai trò là một cơ sở dữ liệu Vector đơn giản (thường là In-Memory Vector Store trong các bản demo) để lưu trữ kiến thức.

- Cơ chế xử lý: Thay vì xử lý tuần tự qua nhiều bước, node này sử dụng một module document gắn kèm là Default Data Loader.

- Default Data Loader: Thành phần này được kết nối trực tiếp vào cổng đầu vào Document của node Simple Vector Store. Nhiệm vụ chính là nhận tệp tin từ Trigger, tự động đọc và trích xuất nội dung văn bản, sau đó “mớm” dữ liệu sạch này vào ngay bên trong Simple Vector Store để thực hiện việc lưu trữ.

Luồng truy xuất và hội thoại (Retriever Flow)

Luồng này đảm nhiệm việc tương tác với người dùng và trả lời câu hỏi dựa trên dữ liệu vừa nạp.

Node “When chat message received” (Chat Trigger):

Khởi động quy trình khi có tin nhắn mới từ giao diện chat (có thể thay thế tùy vào trường hớp sử dụng thực tế).

Node “AI Agent”:

Trung tâm điều khiển của Chatbot. Node này bao gồm OpenAI Chat Model và Simple Vector Store tool.

Khi AI Agent cần thông tin, tool này sẽ tìm kiếm các đoạn văn bản tương đồng trong bộ nhớ và trả về kết quả cho AI xử lý.

Thành phần cốt lõi dùng chung: Embeddings OpenAI

Đây là yếu tố kỹ thuật bắt buộc để hai luồng có thể “hiểu” nhau.

- Vị trí và kết nối: Node Embeddings OpenAI nằm ở phía dưới và kết nối vào cổng Embeddings của cả node Simple Vector Store bên Load Data Flow và Retriever Flow.

- Vai trò: Việc sử dụng chung một node đảm bảo rằng thuật toán mã hóa dữ liệu đầu vào và thuật toán mã hóa câu hỏi truy vấn là hoàn toàn giống nhau. Nếu sử dụng hai node Embeddings khác nhau, hệ thống sẽ không thể tìm thấy dữ liệu chính xác do sự sai lệch về không gian số học vector.

Một số lưu ý để tối ưu hóa hiệu suất RAG trên n8n

Việc kết nối các node thành công chỉ là bước khởi đầu. Để hệ thống RAG hoạt động thông minh, phản hồi nhanh và chính xác, người quản trị cần chú trọng đến các yếu tố kỹ thuật sau đây:

Chiến lược phân đoạn văn bản (Chunking Strategy)

Kích thước của các đoạn văn bản (Chunk size) ảnh hưởng trực tiếp đến chất lượng câu trả lời.

- Kích thước quá nhỏ: AI có thể mất ngữ cảnh cần thiết để hiểu trọn vẹn ý nghĩa.

- Kích thước quá lớn: Dữ liệu tìm được sẽ chứa nhiều thông tin nhiễu không liên quan, làm giảm độ chính xác của câu trả lời.

- Giải pháp: Trong n8n, hãy bắt đầu với Chunk Size khoảng 500-1000 token và quan trọng là thiết lập Chunk Overlap (độ chồng lặp) khoảng 10-20%. Sự chồng lặp giúp giữ mạch liên kết giữa các đoạn cắt, đảm bảo không có thông tin quan trọng nào bị đứt gãy giữa chừng.

Chất lượng dữ liệu đầu vào

Hệ thống RAG hoạt động theo nguyên tắc “Rác vào, rác ra” (Garbage In, Garbage Out). Trước khi nạp tài liệu vào node Simple Vector Store, hãy đảm bảo loại bỏ các thành phần không cần thiết như tiêu đề trang, số trang, header/footer lặp lại hoặc các ký tự đặc biệt gây nhiễu. Dữ liệu càng sạch, khả năng tìm kiếm của Vector Store càng chính xác.

Tối ưu hóa câu lệnh hệ thống

Trong node AI Agent, phần “System Message” đóng vai trò định hướng hành vi cho Chatbot. Hãy thiết lập một chỉ thị rõ ràng và nghiêm ngặt.

Ví dụ: “Bạn là trợ lý AI hữu ích. Chỉ được trả lời dựa trên thông tin ngữ cảnh được cung cấp. Nếu không tìm thấy thông tin trong tài liệu, hãy trả lời rằng tôi không biết, tuyệt đối không được tự bịa ra thông tin.” Chỉ thị này giúp ngăn chặn hiện tượng ảo giác (hallucination) thường gặp ở các mô hình ngôn ngữ lớn.

Lựa chọn mô hình Embeddings phù hợp

Dù OpenAI Embeddings là lựa chọn phổ biến, nhưng đối với các tài liệu tiếng Việt chuyên ngành, người dùng có thể cân nhắc các mô hình khác hỗ trợ đa ngôn ngữ tốt hơn. Tuy nhiên, cần lưu ý nguyên tắc bất di bất dịch: Mô hình dùng để mã hóa khi nạp dữ liệu và mô hình dùng để truy vấn phải là một.

Ứng dụng thực tế của RAG với n8n

Khả năng tùy biến linh hoạt của n8n cho phép triển khai kỹ thuật RAG vào nhiều quy trình nghiệp vụ khác nhau trong doanh nghiệp:

- Trợ lý ảo hỗ trợ khách hàng: Tự động trả lời các câu hỏi thường gặp dựa trên kho tài liệu hướng dẫn sử dụng, chính sách bảo hành hoặc catalog sản phẩm. Hệ thống này giúp giảm tải cho đội ngũ nhân sự và hoạt động liên tục 24/7.

- Hệ thống tra cứu quy trình nội bộ: Nhân viên mới thường mất nhiều thời gian để tìm hiểu quy định công ty. Một Chatbot RAG tích hợp trên Slack hoặc Microsoft Teams (qua n8n) có thể giúp nhân viên tra cứu nhanh thông tin về quy trình xin nghỉ phép, phúc lợi, hay quy định bảo mật chỉ trong vài giây.

- Phân tích hợp đồng và văn bản pháp lý: Nạp các tệp PDF hợp đồng dài hàng trăm trang vào hệ thống. Sau đó, người dùng có thể đặt các câu hỏi cụ thể như “Điều khoản phạt chậm thanh toán là bao nhiêu?” hoặc “Thời hạn hiệu lực của hợp đồng là khi nào?” để AI trích xuất thông tin chính xác.

- Tóm tắt và khai thác tin tức thị trường: Kết hợp node HTTP Request để tự động cào nội dung từ các trang báo điện tử, nạp vào Vector Store và yêu cầu AI tổng hợp các xu hướng mới nhất hàng ngày gửi về email.

Kết luận

Sự kết hợp giữa RAG và n8n đã mở ra một kỷ nguyên mới cho việc tự động hóa quy trình xử lý thông tin. Không còn bị giới hạn bởi những rào cản kỹ thuật phức tạp, giờ đây bất kỳ doanh nghiệp nào cũng có thể tự xây dựng cho mình một trợ lý AI thông minh, am hiểu dữ liệu nội bộ và hoạt động không mệt mỏi. Giải pháp này không chỉ giúp tiết kiệm thời gian tra cứu mà còn nâng cao đáng kể độ chính xác trong việc ra quyết định.

Những câu hỏi thường gặp

Tôi có cần biết lập trình để xây dựng RAG trên n8n không?

Không nhất thiết. n8n cung cấp giao diện kéo thả trực quan và các mẫu (Template) có sẵn. Tuy nhiên, việc hiểu cơ bản về cấu trúc dữ liệu JSON sẽ giúp quá trình tùy chỉnh thuận lợi hơn.

Chi phí để vận hành hệ thống RAG này là bao nhiêu?

Chi phí chủ yếu đến từ việc sử dụng API của OpenAI (hoặc nhà cung cấp AI khác) và chi phí lưu trữ Vector Database. Bản thân n8n có phiên bản Self-hosted miễn phí nếu người dùng tự cài đặt trên máy chủ cá nhân.

Dữ liệu của tôi có được bảo mật không?

Khi sử dụng n8n bản Self-hosted, dữ liệu hoàn toàn nằm trong quyền kiểm soát của doanh nghiệp. Tuy nhiên, khi gửi dữ liệu đến OpenAI để xử lý, thông tin sẽ tuân theo chính sách bảo mật của OpenAI (thường là không dùng dữ liệu API để huấn luyện model, nhưng cần kiểm tra kỹ chính sách hiện hành).

Tại sao Chatbot trả lời sai hoặc không tìm thấy thông tin?

Nguyên nhân thường do Chunk Size chưa hợp lý hoặc dữ liệu đầu vào quá nhiễu. Hãy thử điều chỉnh lại cách chia nhỏ văn bản hoặc kiểm tra lại nội dung file nguồn.

Tôi có thể sử dụng các mô hình AI miễn phí (Local LLM) không?

Có. n8n hỗ trợ tích hợp với Ollama. Người dùng có thể chạy các mô hình như Llama 3 hoặc Mistral ngay trên máy chủ của mình để tiết kiệm chi phí và tăng cường bảo mật.

Hệ thống có hỗ trợ tiếng Việt tốt không?

Có, nhưng chất lượng phụ thuộc lớn vào mô hình Embeddings và Chat Model. Các model hiện đại như GPT-4o xử lý tiếng Việt rất mượt mà.

![Phần mềm Nhanh.vn là gì? Đánh giá hệ thống quản lý bán hàng đa kênh hàng đầu [2026]](https://tino.vn/blog/wp-content/uploads/2026/02/phan-mem-nhanh-vn-la-gi-cover-150x150.png)