Trong kỷ nguyên số, dữ liệu được ví như tài sản vô giá của mọi doanh nghiệp. Tuy nhiên, việc thu thập thông tin thủ công từ hàng nghìn trang web là một nhiệm vụ bất khả thi về mặt thời gian và nhân lực. Đây là lúc Scrapy phát huy vai trò tối quan trọng. Vậy Scrapy là gì? Bài viết dưới đây sẽ giúp bạn hiểu rõ cơ chế hoạt động cũng như cách triển khai framework này cho các dự án dữ liệu.

Tổng quan về Scrapy

Scrapy là gì?

Scrapy là một framework ứng dụng mã nguồn mở và cộng tác, được viết bằng ngôn ngữ lập trình Python, chuyên dùng để trích xuất dữ liệu từ các trang web (web scraping). Công cụ này cung cấp một nền tảng mạnh mẽ giúp người dùng thu thập thông tin nhanh chóng, đơn giản và có khả năng mở rộng quy mô một cách linh hoạt.

Thay vì chỉ hoạt động như một thư viện đơn lẻ, Scrapy mang đến một bộ khung hoàn chỉnh để quản lý các yêu cầu mạng, xử lý dữ liệu thô và lưu trữ kết quả cuối cùng theo định dạng mong muốn. Framework này hiện được ứng dụng rộng rãi trong nhiều lĩnh vực quan trọng như khai phá dữ liệu, giám sát thông tin và kiểm thử tự động.

Lịch sử hình thành và phát triển

Scrapy khởi nguồn là một dự án nội bộ tại Mycroes, một công ty chuyên về trích xuất dữ liệu web và thương mại điện tử có trụ sở tại London. Hai nhà đồng sáng lập Pablo Hoffman và Shane Evans đã thiết kế và xây dựng framework này nhằm tối ưu hóa quy trình làm việc.

Năm 2008, mã nguồn của dự án chính thức được công bố rộng rãi theo giấy phép BSD, mở ra kỷ nguyên phát triển mạnh mẽ dựa trên sự đóng góp của cộng đồng. Một cột mốc quan trọng diễn ra vào năm 2015 khi phiên bản 1.0 ra mắt, đánh dấu sự trưởng thành và ổn định của nền tảng. Hiện nay, Scrapy được duy trì và bảo trợ bởi Zyte (trước đây là Scrapinghub) cùng cộng đồng lập trình viên Python trên toàn cầu.

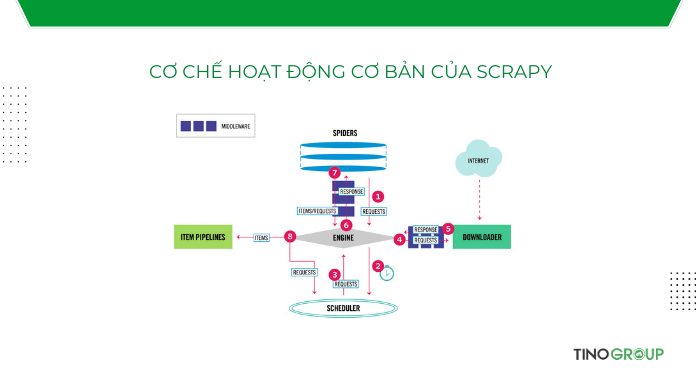

Cơ chế hoạt động cơ bản của Scrapy

Kiến trúc của Scrapy được thiết kế xoay quanh một trung tâm điều khiển luồng dữ liệu, vận hành dựa trên cơ chế bất đồng bộ (asynchronous). Điều này cho phép hệ thống thực hiện nhiều tác vụ cùng lúc mà không cần chờ đợi tác vụ trước đó hoàn thành, giúp tối ưu hóa tốc độ xử lý.

Quy trình vận hành của Scrapy diễn ra qua các bước phối hợp chặt chẽ giữa các thành phần sau:

- Scrapy Engine (Bộ máy trung tâm): Đây là thành phần cốt lõi, chịu trách nhiệm điều phối luồng dữ liệu giữa tất cả các bộ phận khác trong hệ thống. Scrapy Engine sẽ kích hoạt các sự kiện và đảm bảo dữ liệu di chuyển đúng hướng.

- Scheduler (Bộ lập lịch): Thành phần này nhận các yêu cầu (requests) từ Scrapy Engine và sắp xếp các yêu cầu này vào hàng đợi. Khi Engine sẵn sàng xử lý, Scheduler sẽ gửi lại yêu cầu tiếp theo để thực hiện.

- Downloader (Bộ tải xuống): Downloader có nhiệm vụ tìm nạp các trang web và tải nội dung về dựa trên các yêu cầu được gửi đến. Sau khi tải xong, bộ phận này sẽ chuyển phản hồi (response) chứa nội dung trang web ngược lại cho Engine để chuyển tiếp đến các thành phần xử lý.

- Spiders (Trình thu thập): Đây là nơi người dùng viết mã để định nghĩa cách thức thu thập dữ liệu. Spiders sẽ nhận phản hồi từ Downloader (thông qua Engine), sau đó phân tích cú pháp để trích xuất dữ liệu cần thiết (gọi là Items) hoặc tạo ra các yêu cầu mới để tiếp tục đi theo các liên kết khác trên trang web.

- Item Pipeline (Đường ống xử lý dữ liệu): Sau khi dữ liệu được Spiders trích xuất, các thông tin này sẽ được chuyển đến Item Pipeline. Tại đây, dữ liệu sẽ trải qua các bước xử lý hậu kỳ như: làm sạch (xóa bỏ HTML thừa), kiểm tra tính hợp lệ, loại bỏ trùng lặp và cuối cùng là lưu trữ vào cơ sở dữ liệu hoặc xuất ra các định dạng file như JSON, CSV.

Tóm tắt luồng dữ liệu:

Quy trình bắt đầu khi Spider gửi yêu cầu -> Engine chuyển đến Scheduler -> Scheduler trả lại yêu cầu cho Engine -> Engine gửi đến Downloader -> Downloader tải trang và trả về Engine -> Engine gửi dữ liệu thô cho Spider phân tích -> Spider xuất dữ liệu ra Item Pipeline để lưu trữ.

Các tính năng nổi bật tạo nên sức mạnh của Scrapy

Để trở thành công cụ hàng đầu trong lĩnh vực thu thập dữ liệu, Scrapy được trang bị hàng loạt tính năng mạnh mẽ, hỗ trợ tối đa cho lập trình viên trong việc xử lý các tác vụ phức tạp:

- Hỗ trợ trích xuất dữ liệu đa dạng: Framework tích hợp sẵn các bộ chọn (selectors) mạnh mẽ dựa trên XPath và CSS. Tính năng này cho phép định vị và lấy thông tin từ các phần tử HTML hoặc XML một cách chính xác và dễ dàng.

- Môi trường tương tác trực tiếp: Scrapy cung cấp một giao diện dòng lệnh tương tác. Lập trình viên có thể sử dụng công cụ này để thử nghiệm các đoạn mã trích xuất, kiểm tra phản hồi từ website ngay lập tức mà không cần chạy toàn bộ dự án, giúp tiết kiệm đáng kể thời gian gỡ lỗi (debug).

- Xuất dữ liệu linh hoạt Hệ thống hỗ trợ xuất dữ liệu thu thập được ra nhiều định dạng phổ biến như JSON, CSV, XML hoặc lưu trữ trực tiếp vào các cơ sở dữ liệu (MySQL, MongoDB…) thông qua hệ thống Pipeline.

- Xử lý mã hóa thông minh: Scrapy tự động phát hiện và xử lý các vấn đề về mã hóa ký tự (encoding), giúp hiển thị chính xác ngôn ngữ của trang web gốc, bao gồm cả các ngôn ngữ phức tạp.

- Khả năng mở rộng qua Middleware: Kiến trúc của Scrapy cho phép can thiệp vào quy trình xử lý request và response thông qua các lớp trung gian (Middleware). Người dùng có thể tùy chỉnh để xử lý cookie, session, hoặc thay đổi User-Agent nhằm tránh bị chặn bởi website mục tiêu.

5 lý do khiến lập trình viên ưu tiên lựa chọn Scrapy

Giữa vô vàn các thư viện hỗ trợ thu thập dữ liệu, Scrapy vẫn giữ vững vị thế số một trong cộng đồng lập trình viên Python nhờ những ưu điểm vượt trội sau:

#1. Tốc độ xử lý nhanh nhờ cơ chế bất đồng bộ

Khác với các thư viện xử lý tuần tự, Scrapy được xây dựng trên nền tảng Twisted – một framework mạng bất đồng bộ (asynchronous networking). Nhờ đó, công cụ này có thể gửi hàng nghìn yêu cầu cùng một lúc mà không cần đợi yêu cầu trước đó hoàn thành. Đặc điểm này giúp rút ngắn đáng kể thời gian thu thập dữ liệu, đặc biệt khi làm việc với lượng trang web lớn.

#2. Giải pháp “All-in-one” (Tất cả trong một)

Khi sử dụng các thư viện nhỏ lẻ, lập trình viên thường phải tự xây dựng các module để tải trang, xử lý lỗi, hoặc lưu trữ dữ liệu. Scrapy giải quyết vấn đề này bằng cách cung cấp một bộ khung hoàn chỉnh bao gồm tất cả các công cụ cần thiết. Từ việc tải trang, xử lý dữ liệu đến xuất file, mọi thứ đều có sẵn và được tổ chức khoa học.

#3. Khả năng tùy biến và mở rộng cao

Framework được thiết kế để dễ dàng tích hợp thêm các chức năng mới mà không làm phá vỡ cấu trúc cốt lõi. Lập trình viên có thể viết thêm các tiện ích mở rộng (extensions) hoặc kết nối Scrapy với các công cụ khác như Selenium hoặc Splash để xử lý các trang web sử dụng nhiều JavaScript.

#4. Tiết kiệm tài nguyên hệ thống

Nhờ tối ưu hóa quy trình quản lý bộ nhớ và CPU, Scrapy hoạt động rất nhẹ nhàng. Người dùng có thể chạy framework này trên các máy chủ có cấu hình khiêm tốn hoặc thậm chí trên máy tính cá nhân mà vẫn đảm bảo hiệu suất công việc cao.

#5. Cộng đồng hỗ trợ lớn và tài liệu phong phú

Với lịch sử phát triển lâu đời, Scrapy sở hữu một cộng đồng người dùng đông đảo. Mọi thắc mắc hay lỗi kỹ thuật đều dễ dàng tìm thấy lời giải trên các diễn đàn công nghệ hoặc Stack Overflow. Bên cạnh đó, hệ thống tài liệu chính thức (Documentation) của Scrapy được viết rất chi tiết, đầy đủ ví dụ minh họa, giúp người mới bắt đầu tiếp cận nhanh chóng.

Chi phí sử dụng Scrapy như thế nào?

Một trong những ưu điểm lớn nhất khiến Scrapy trở thành lựa chọn hàng đầu của cộng đồng công nghệ nằm ở chính sách chi phí. Về cơ bản, Scrapy là một phần mềm mã nguồn mở (Open Source) và được phát hành dưới giấy phép BSD. Điều này đồng nghĩa với việc:

- Chi phí bản quyền bằng 0: Cá nhân và doanh nghiệp có thể tải về, cài đặt, sử dụng và tùy chỉnh mã nguồn của framework này cho bất kỳ mục đích nào, bao gồm cả mục đích thương mại, mà không phải trả bất kỳ khoản phí cấp phép nào.

Tuy nhiên, “miễn phí bản quyền” không có nghĩa là việc vận hành một hệ thống thu thập dữ liệu sẽ hoàn toàn không tốn kém. Khi triển khai Scrapy vào các dự án thực tế, đặc biệt là quy mô lớn, người quản lý cần tính toán đến các loại chi phí vận hành sau đây:

- Chi phí hạ tầng máy chủ (Server/VPS): Mặc dù Scrapy có thể chạy trên máy tính cá nhân, nhưng để duy trì hoạt động thu thập dữ liệu liên tục 24/7, người dùng cần thuê VPS hoặc các dịch vụ đám mây. Chi phí này phụ thuộc vào cấu hình phần cứng (CPU, RAM) và băng thông mạng yêu cầu.

- Chi phí giải pháp Proxy và IP: Đây thường là khoản chi phí lớn nhất khi thực hiện Web Scraping. Để tránh bị các trang web mục tiêu chặn hoặc khóa quyền truy cập, hệ thống cần sử dụng mạng lưới Proxy để xoay vòng địa chỉ IP liên tục. Các dịch vụ Proxy chất lượng cao thường tính phí dựa trên dung lượng băng thông sử dụng.

- Chi phí giải mã Captcha và chống Bot (Anti-Bot): Đối với các trang web có cơ chế bảo mật cao (như Cloudflare, Datadome), Scrapy đơn thuần có thể không vượt qua được. Khi đó, lập trình viên cần tích hợp thêm các dịch vụ bên thứ ba để giải mã Captcha hoặc sử dụng các trình duyệt hỗ trợ (như Splash, Selenium) – điều này sẽ làm tăng tài nguyên máy chủ hoặc phát sinh phí dịch vụ.

- Chi phí nhân sự và bảo trì: Website mục tiêu thường xuyên thay đổi cấu trúc giao diện. Mỗi khi có sự thay đổi này, Spider (trình thu thập) sẽ ngừng hoạt động hoặc lấy sai dữ liệu. Do đó, doanh nghiệp cần phân bổ ngân sách cho nhân sự kỹ thuật để thường xuyên giám sát, cập nhật và chỉnh sửa mã nguồn cho phù hợp với cấu trúc mới.

Hướng dẫn cài đặt và tạo dự án Scrapy đầu tiên

Yêu cầu hệ thống và cài đặt

Trước khi bắt đầu, máy tính cần được cài đặt sẵn ngôn ngữ lập trình Python (khuyến nghị phiên bản 3.8 trở lên). Người dùng có thể kiểm tra phiên bản Python hiện tại bằng cách gõ lệnh python --version trong cửa sổ dòng lệnh (Terminal hoặc Command Prompt).

Để cài đặt Scrapy, hãy sử dụng trình quản lý gói pip. Mở cửa sổ dòng lệnh và nhập câu lệnh sau:

pip install scrapyQuá trình cài đặt sẽ diễn ra tự động. Hệ thống sẽ tải về Scrapy cùng các thư viện phụ thuộc cần thiết như Twisted, lxml, cssselect.

Khởi tạo dự án (Project)

Sau khi cài đặt hoàn tất, bước tiếp theo là tạo một dự án mới. Hãy di chuyển đến thư mục muốn lưu trữ mã nguồn và thực thi lệnh:

scrapy startproject tutorial_scraperLệnh này sẽ tạo ra một thư mục có tên tutorial_scraper. Bên trong thư mục này chứa cấu trúc chuẩn của một dự án Scrapy, bao gồm:

- scrapy.cfg: Tệp cấu hình cấu hình dự án.

- items.py: Nơi định nghĩa các trường dữ liệu muốn thu thập.

- middlewares.py: Nơi tùy chỉnh các xử lý trung gian.

- pipelines.py: Nơi xử lý dữ liệu sau khi thu thập (làm sạch, lưu database).

- settings.py: Nơi cài đặt các thông số như tốc độ, robot rules, user-agent.

- spiders/: Thư mục chứa các file mã nguồn của bot thu thập.

Tạo Spider (Trình thu thập)

Spider là nơi chứa logic chính để điều hướng và trích xuất dữ liệu. Để tạo một Spider mới, hãy sử dụng lệnh genspider với cú pháp:

cd tutorial_scraper

scrapy genspider quotes quotes.toscrape.comLệnh trên sẽ tạo ra một file quotes.py nằm trong thư mục spiders/. Hãy mở file này bằng trình soạn thảo code (như VS Code) và người dùng sẽ thấy cấu trúc mặc định. Dưới đây là đoạn mã đã được chỉnh sửa đơn giản để lấy Tiêu đề (Title) của các câu trích dẫn:

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

allowed_domains = ["quotes.toscrape.com"]

start_urls = ["https://quotes.toscrape.com/"]

def parse(self, response):

# Lặp qua từng khối trích dẫn trên trang web

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('small.author::text').get(),

}Giải thích mã lệnh:

- name: Tên định danh của Spider (duy nhất trong dự án).

- start_urls: Danh sách các đường dẫn mà Spider sẽ bắt đầu truy cập.

- parse: Hàm mặc định để xử lý phản hồi từ trang web.

- response.css: Sử dụng CSS Selector để chọn phần tử HTML mong muốn.

- yield: Trả về dữ liệu dưới dạng từ điển (dictionary).

Chạy dự án và xuất dữ liệu

Để kích hoạt Spider và xem kết quả, hãy quay lại cửa sổ dòng lệnh và chạy lệnh:

scrapy crawl quotesNếu muốn lưu kết quả thu thập được ra một file cụ thể (ví dụ JSON) để sử dụng sau này, hãy thêm tham số -O (overwrite – ghi đè) hoặc -o (append – ghi nối tiếp):

scrapy crawl quotes -O ketqua.jsonSau khi lệnh thực thi xong, một file ketqua.json sẽ xuất hiện trong thư mục dự án, chứa toàn bộ danh sách các câu trích dẫn và tác giả đã được lấy về từ trang web.

Những lưu ý quan trọng để tránh bị chặn IP khi dùng Scrapy

Thay đổi định danh người dùng (Fake User-Agent)

Theo mặc định, Scrapy sẽ gửi yêu cầu đến máy chủ với định danh thật là “Scrapy/VERSION”. Đây là dấu hiệu rõ ràng nhất để các website phát hiện và chặn ngay lập tức. Giải pháp tối ưu là thay đổi thông tin này thành chuỗi ký tự của các trình duyệt phổ biến (như Chrome, Firefox hoặc Safari). Việc ngụy trang này giúp bot hòa nhập vào lưu lượng truy cập của người dùng thật.

Thiết lập độ trễ hợp lý (Download Delay)

Một sai lầm phổ biến của người mới bắt đầu là cố gắng tải dữ liệu nhanh nhất có thể. Hành động gửi hàng trăm yêu cầu (request) trong một giây sẽ tạo ra áp lực lớn lên máy chủ đích và kích hoạt cơ chế phòng thủ DdoS. Hãy thiết lập thông số DOWNLOAD_DELAY trong cấu hình để tạo ra khoảng nghỉ giữa các lần gửi yêu cầu. Một tốc độ chậm rãi, từ tốn không chỉ giúp tránh bị chặn mà còn thể hiện sự tôn trọng đối với tài nguyên của website mục tiêu.

Sử dụng mạng lưới Proxy và xoay vòng IP

Ngay cả khi đã giảm tốc độ, việc gửi liên tục các yêu cầu từ một địa chỉ IP duy nhất trong thời gian dài vẫn rất đáng ngờ. Để khắc phục, người dùng nên tích hợp một mạng lưới Proxy (trung gian). Bằng cách xoay vòng (Rotate) địa chỉ IP liên tục cho mỗi yêu cầu gửi đi, hệ thống bảo mật của website sẽ lầm tưởng rằng lưu lượng truy cập đến từ nhiều người dùng khác nhau ở khắp nơi trên thế giới, thay vì từ một con bot duy nhất.

Tắt cơ chế lưu Cookie (Disable Cookies)

Nhiều trang web sử dụng Cookie để theo dõi hành vi người dùng. Nếu Scrapy giữ lại Cookie và gửi kèm trong các yêu cầu liên tiếp, website có thể xâu chuỗi hành vi và phát hiện ra quy luật hoạt động của bot. Việc vô hiệu hóa chức năng gửi Cookie (nếu trang web không yêu cầu đăng nhập) sẽ giúp mỗi lần truy cập trở nên độc lập và khó bị theo dõi hơn.

Tận dụng tính năng AutoThrottle

Scrapy được tích hợp sẵn một tiện ích mở rộng thông minh tên là AutoThrottle. Khi được kích hoạt, tiện ích này sẽ tự động điều chỉnh tốc độ tải trang dựa trên độ trễ phản hồi của máy chủ và tình trạng mạng hiện tại. Cơ chế này giúp framework hoạt động linh hoạt: giảm tốc khi máy chủ quá tải và tăng tốc khi điều kiện cho phép, đảm bảo sự cân bằng giữa hiệu suất và an toàn.

Tuân thủ tập tin Robots.txt

Hầu hết các website đều có một tập tin robots.txt quy định những khu vực nào cho phép hoặc cấm thu thập dữ liệu. Mặc dù Scrapy có tùy chọn bỏ qua quy định này (ROBOTSTXT_OBEY = False), nhưng việc tôn trọng các chỉ dẫn này là một hành động văn minh. Tuân thủ robots.txt không chỉ giúp tránh các rắc rối về pháp lý mà còn giảm thiểu nguy cơ bị quản trị viên đưa địa chỉ IP vào danh sách đen vĩnh viễn.

Kết luận

Với kiến trúc mạch lạc, tốc độ xử lý vượt trội nhờ cơ chế bất đồng bộ và khả năng mở rộng không giới hạn, framework này xứng đáng là “vũ khí” chủ lực trong tay các lập trình viên Python. Nếu doanh nghiệp hoặc cá nhân đang tìm kiếm một giải pháp để khai thác thông tin từ Internet một cách tự động, chính xác và hiệu quả, việc đầu tư thời gian để làm chủ Scrapy là một quyết định hoàn toàn đúng đắn. Hãy bắt đầu cài đặt và viết những dòng mã đầu tiên ngay hôm nay để trải nghiệm sức mạnh của công cụ này.

Những câu hỏi thường gặp

Scrapy khác biệt gì so với Beautiful Soup?

Beautiful Soup chỉ là một thư viện dùng để phân tích cú pháp HTML (parsing) và lấy dữ liệu từ một chuỗi văn bản cụ thể. Trong khi đó, Scrapy là một framework trọn gói (full-stack); công cụ này không chỉ phân tích dữ liệu mà còn quản lý việc tải trang, gửi yêu cầu mạng, xử lý lỗi và lưu trữ kết quả. Người dùng có thể kết hợp cả hai: dùng Scrapy để tải trang và dùng Beautiful Soup để lọc nội dung bên trong Scrapy.

Scrapy có xử lý được các trang web sử dụng nhiều JavaScript (như React, VueJS) không?

Mặc định, Scrapy chỉ tải mã nguồn HTML tĩnh và không tự động chạy các đoạn mã JavaScript. Để thu thập dữ liệu từ các trang web động này, lập trình viên cần tích hợp thêm công cụ hỗ trợ như Scrapy-Splash hoặc Selenium để giả lập trình duyệt và render nội dung trước khi lấy dữ liệu.

Scrapy có giao diện web hay ứng dụng trực quan không?

Không. Scrapy hoạt động hoàn toàn dựa trên giao diện dòng lệnh và yêu cầu người sử dụng viết mã nguồn để điều khiển. Framework này không tích hợp sẵn giao diện đồ họa (GUI) kiểu kéo-thả như các phần mềm thương mại (ví dụ: Octoparse). Tuy nhiên, lập trình viên có thể cài đặt thêm các công cụ quản trị bên thứ ba (như ScrapydWeb) hoặc sử dụng dịch vụ đám mây để quản lý và theo dõi tiến trình thu thập thông qua trình duyệt web.

Scrapy có thể tải hình ảnh hoặc tệp tin về máy không?

Hoàn toàn được. Scrapy cung cấp sẵn một tính năng gọi là Media Pipeline (bao gồm Images Pipeline và Files Pipeline). Tính năng này giúp tự động tải xuống hình ảnh hoặc tệp tin từ các đường dẫn thu thập được, đồng thời hỗ trợ chuyển đổi định dạng hoặc tạo hình thu nhỏ (thumbnail).

Có giới hạn nào về số lượng trang web mà Scrapy có thể thu thập không?

Về mặt lý thuyết là không. Giới hạn duy nhất nằm ở tài nguyên phần cứng (RAM, CPU, băng thông mạng) của máy tính đang chạy Scrapy và thời gian người dùng cho phép hệ thống hoạt động. Framework này đủ sức xử lý hàng triệu trang web nếu hạ tầng đáp ứng đủ.

Scrapy có thể chạy trên hệ điều hành Windows không?

Có. Scrapy là một framework đa nền tảng (Cross-platform). Công cụ này hoạt động ổn định trên cả Windows, macOS và Linux. Tuy nhiên, việc cài đặt trên Windows đôi khi yêu cầu cài thêm một số thư viện C++ hỗ trợ (như Microsoft Visual C++ Build Tools).

![Phần mềm Nhanh.vn là gì? Đánh giá hệ thống quản lý bán hàng đa kênh hàng đầu [2026]](https://tino.vn/blog/wp-content/uploads/2026/02/phan-mem-nhanh-vn-la-gi-cover-150x150.png)

![Phần mềm Sapo là gì? Đánh giá giải pháp quản lý bán hàng đa kênh hàng đầu [2026]](https://tino.vn/blog/wp-content/uploads/2026/02/phan-mem-sapo-la-gi-cover-150x150.png)

![Phần mềm KiotViet là gì? Đánh giá chi tiết phần mềm quản lý bán hàng “quốc dân” [2026]](https://tino.vn/blog/wp-content/uploads/2026/02/kiotviet-la-gi-cover-150x150.png)